AnaisWRVA2010

-

Upload

presencavirtual -

Category

Documents

-

view

2.228 -

download

2

Transcript of AnaisWRVA2010

VII WORKSHOP DE REALIDADE

VIRTUAL E AUMENTADA

WRVA'2010

08 a 11 de Novembro de 2010 São Paulo SP Brasil

Computação e InformáticaFaculdade de

ii

ANAIS WRVA'2010

VII WORKSHOP DE REALIDADE VIRTUAL E AUMENTADA

São Paulo (SP), 08 a 11 de Novembro de 2010

COORDENADOR

Luciano Silva Universidade Presbiteriana Mackenzie ‐ MACKENZIE

EDITADO POR

Luciano Silva Universidade Presbiteriana Mackenzie ‐ MACKENZIE

iii

006.3 W873

Workshop de Realidade Virtual e Aumentada; 7. : 2010 : São Paulo, SP. [Anais do] WRVA’2010 7 Workshop de Realidade Virtual e Aumentada, 08 a 11 de Novembro de 2010, São Paulo ‐ SP / Luciano Silva (org.). – São Paulo : MackPesquisa, Mackenzie‐Faculdade de Computação e Informática : Sociedade Brasileira de Computação 2010. 313p. + xx Bibliografia ISSN 1982‐1657 1. Realidade Virtual. 2. Realidade Aumentada. 3. Linguagens – Bibliotecas.

I. Silva, Luciano. II. Título.

iv

PROCEEDINGS WRVA'2010

VII WORKSHOP ON VIRTUAL AND AUGMENTED REALITY

São Paulo (SP), November 08‐11, 2010

CHAIR

Luciano Silva Universidade Presbiteriana Mackenzie ‐ MACKENZIE

EDITED BY

Luciano Silva Universidade Presbiteriana Mackenzie ‐ MACKENZIE

v

WRVA'2010 VII WORKSHOP DE REALIDADE VIRTUAL E AUMENTADA

Realização:

Computação e InformáticaFaculdade de

Apoio:

vi

WRVA'2010 VII WORKSHOP DE REALIDADE VIRTUAL E AUMENTADA

Comitê Organizador

Luciano Silva (Chair) ‐ Mackenzie‐SP Beatriz de Almeida Pacheco Fronterotta (Vice‐Chair) ‐ Mackenzie‐SP Ismar Frango Silveira ‐ Mackenzie‐SP Ilana de Almeida Souza ‐ Mackenzie‐SP Maria Amelia Eliseo‐ Mackenzie‐SP

vii

WRVA'2010 VII WORKSHOP DE REALIDADE VIRTUAL E AUMENTADA

Comitê de Programa

Luciano Pereira Soares ‐ Chair ‐ PUC/RJ José Remo Ferreira Brega ‐ Vice‐Chair ‐ UNESP/Bauru Alberto Raposo ‐ PUC‐Rio Alexandre Cardoso ‐ UFU Anderson Maciel ‐ UFRGS Antonio Carlos Sementille ‐ UNESP Arthur Augusto Bastos Buccioli – UEMG Asla Medeiros e Sá ‐ FGV Beatriz de Almeida Pacheco ‐ MACKENZIE‐SP Bianchi Serique Meiguinis – UFPA Carlos Morimoto ‐ USP Celso Kurashima ‐ UFABC Claudio Kirner ‐ UNIFEI Creto Vidal ‐ UFC Cristina Vasconcelos ‐ UFF Daniela Kutschat Hanns ‐ SENAC‐SP Edgard Afonso Lamounier Júnior – UFU Eduardo Albuquerque ‐ UFG Eliane Raimann ‐ IFET/GO Eunice Nunes ‐ UFMT Ezequiel Roberto Zorzal ‐ IFET/SP Fátima de Lourdes dos Santos Nunes – USP Glauco Todesco ‐ Universidade de Sorocaba Ildeberto Aparecido Rodello ‐ FEARP/USP Joaquim Bento Cavalcante‐Neto ‐ UFC José Barbosa Jr. ‐ UFU e IFET/GO Jose Paiva ‐ UFU Jucelino Araujo ‐ Iles/Ulbra

viii

Judith Kelner ‐ UFPE Kenedy Lopes Nogueira ‐ UFU Luciana Nedel ‐ UFRGS Luciano Silva ‐ Mackenzie‐SP Liliane Machado – UFPB Luiz Fernando Braga Lopes – UFU Manuel Loaiza ‐ PUC‐Rio Marcelo de Paiva ‐ Faculdade Campo Limpo Paulista Marcio Lobo Netto ‐ USP Marcos Wagner Souza Ribeiro ‐ UFG ‐ Jataí Mario Massakuni Kubo ‐ FATEB Monica Oliveira ‐ UFU Paulo Bressan ‐ Universidade Federal de Alfenas Robson Siscoutto ‐ Universidade de Cuiabá Romero Tori ‐ USP e Senac/SP Rosa Maria Costa ‐ UERJ Selan Rodrigues dos Santos ‐ UFRN Veronica Teichrieb – UFPE Wender Antônio da Silva ‐ UFRR

ix

WRVA'2010 VII WORKSHOP DE REALIDADE VIRTUAL E AUMENTADA

Revisores

Alberto Raposo PUC‐RioAlexandre Cardoso UFUAnderson Maciel Universidade Federal do Rio Grande do SulAntonio Carlos Sementille Universidade Estadual Paulista ‐ UNESPArthur Augusto Bastos Bucioli

Universidade Federal de Uberlândia

Asla Medeiros e Sá Fundação Getúlio VargasBianchi Meiguins Universidade Federal do Pará Carlos Morimoto USPCelso Kurashima Universidade Federal do ABC Claudio Kirner Universidade Federal de Itajubá ‐ UNIFEICreto Vidal Federal University of Ceará Cristina Vasconcelos Universidade Federal Fluminense Daniel Trindade Pontificia Universidade Católica Daniela Kutschat Hanns CAS_SENAC SP/ FAUUSPEdgard Lamounier UFUEduardo Albuquerque UFGEliane Raimann IFGoias ‐ JataíEunice Nunes Universidade Federal de Mato GrossoEzequiel Roberto Zorzal Universidade Federal de São Paulo ‐ UNIFESPFatima Nunes EACH‐USPGlauco Todesco Universidade de Sorocaba Henrique Debarba Universidade de Caxias do Sul Herbet Rodrigues Universidade Federal da Paraíba Ildeberto Rodello FEARP ‐ USPJerônimo Grandi Universidade de Caxias do Sul Joaquim Bento Cavalcante‐Neto

Universidade Federal do Ceará

Jose Remo F. Brega UNESP ‐ BauruJose Paiva Universidade Federal de Uberlandia Jucelio C. Araujo Iles‐Ulbra

x

Judith Kelner CIn ‐ UFPEKenedy Nogueira Universidade Federal de Uberlândia Leonardo Fischer Universidade Federal do Rio Grande do SulLiliane Machado Universidade Federal da Paraíba Lucas Teixeira PUC‐RioLuciana Nedel UFRGSLuciano Silva Universidade Presbiteriana MackenzieLuciano Soares PUC‐Rio ‐ Pontifícia Universidade Católica do

Rio de Janeiro Luiz Fernando Braga Lopes UFUManuel Loaiza Tecgraf ‐ Depto. de Informática, PUC‐RioMarcelo de Paiva Guimarães

Instituto Fed. de São Paulo/Faculdade Campo Limpo Paulista

Marcio Netto EPUSPMarcos Wagner Souza Ribeiro Universidade Federal de Goiás ‐ Campus Jataí Marcus Alencar PUCMarilena Maule UFRGSMario Kubo FATEPMonica Oliveira UFUPaulo Bressan Universidade Federal de Alfenas Robson Siscoutto Universidade de CuiabáRomero Tori Centro Universitário Senac / Universidade de

Sao Paulo Rosa Maria Costa Universidade do Estado do Rio de JaneiroSelan dos Santos Universidade Federal do Rio Grande do NorteThaise Costa UFPBVeronica Teichrieb Centro de Informática ‐ UFPE Wender Silva Universidade Federal de Roraima

xi

SUMÁRIO

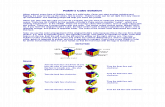

Mensagem ‐ Presidente da CERV ................................................................... 1 Mensagem ‐ Comitê Organizador ................................................................... 2 Mensagem ‐ Comitê de Programa ................................................................... 3 Mini‐cursos ............................................................................................................ 4 Palestras ............................................................................................................ 5 TRABALHOS COMPLETOS/FULL PAPERS Jogos em Realidade Virtual e Aumentada Chair: Ilana de Almeida Souza Uma Arquitetura para Integração de Sistemas Hápticos e Engines de Jogos ........................... 8 Herbet Rodrigues, Liliane Machado, Universidade Federal da Paraíba, Brasil. Análise de um Sistema de Interação Tangível 3D para Jogos com Realidade Aumentada ...... 14 Daniel Tokunaga, University of São Paulo, Brasil Silvio Sanches, Escola Politécnica da Universidade de São Paulo, Brasil Fernando Tsuda, Escola Politécnica da USP, Brasil Ricardo Nakamura, POLI‐USP, Brasil Romero Tori, Centro Universitário Senac / Universidade de Sao Paulo, Brasil. Livro Interativo de Xadrez Potencializado com Realidade Aumentada .................................... 20 Raryel Souza, Universidade Federal de Itajubá (UNIFEI), Brasil Claudio Kirner, Universidade Federal de Itajubá ‐ UNIFEI, Brasil. Desenvolvimento de um Jogo Tridimensional com Realidade Aumentada ............................. 26 Kleber Silva, UNIFEI, Brasil, Claudio Kirner, Universidade Federal de Itajubá ‐ UNIFEI, Brasil.

xii

Aplicações em Engenharia Elétrica Chair: Ismar Frango Silveira Realidade Aumentada para Auxiliar o Aprendizado de Motor Elétrico ................................. 32 Roberto Costa Junior, Roberto Claudino da Silva, Christopher Cerqueira, Universidade Federal de Itajubá, Brasil Antonio Almeida, UNIFEI, Brasil. Ferramenta de Auxilio ao Aprendizado de Motores com o Uso de Realidade Virtual ............ 37 Wedson Gomes, Universidade Federal de Uberlândia, Brasil Edgard Lamounier, Alexandre Cardoso, UFU, Brasil. Uso de Realidade Aumentada na melhoria do processo de ensino‐aprendizagem ............... 42 de motores elétricos Fábio Henrique Monteiro Oliveira, Universidade Federal de Uberlândia, Brasil Eliane Raimann, IFGoias ‐ Jataí, Brasil Edgard Lamounier, Alexandre Cardoso, UFU, Brasil. Desenvolvimento de uma Arquitetura para Distribuição de Realidade Aumentada na Web Aplicada ao Ensino de Motores de Corrente Contínua ......................... 47 Marlus Dias Silva, Eduardo Santos, Universidade Federal de Uberlândia, Brasil Renato Oliveira Abreu, Instituto Federal de Educação, Ciência e Tecnologia de Goiás, Brasil Alexandre Cardoso, Edgard Lamounier, UFU, Brasil.

Ambientes Virtuais Chair: Alexandre Cardoso Humano Virtual ou Virtual Humano ‐ O devir do processo de criação em ambientes imersivos ................................................................................................................. 54 Luciana Louro, Donizetti Louro, Pontificia Universidade Catolica de São Paulo, Brasil. Museu 3I: Publicação e Visitação Online de Acervos Tridimensionais .................................... 60 Eduardo Lucena Falcão, UFPB, Brasil Liliane Machado, Universidade Federal da Paraíba, Brasil. X3D e Integração Multimídia para Representação de um Sítio Arqueológico ........................ 66 Daniel Pires de S∙ Medeiros, UFPB, Brasil. Liliane Machado, Universidade Federal da Paraíba, Brasil. Sistema Solar com Realidade Aumentada ........................................................... 72 Eduardo Okawa, Universidade Federal de Itajubá, Brasil Claudio Kirner, Universidade Federal de Itajubá ‐ UNIFEI, Brasil Tereza Kirner, UNIFEI, Brasil.

xiii

Técnicas de Interação Chair: José Remo Ferreira Brega Reconhecimento de Gestos com Segmentação de Imagens Dinâmicas Aplicadas a Libras ...................................................................................................................... 78 Adilson Pavan, Fábio Caravieri Modesto, Anhanguera Educacional, Brasil. Controle de Navegação em Ambientes Virtuais 3D através do Rastreamento de Objetos ..... 84 Matheus Gadelha, Selan dos Santos, Universidade Federal do Rio Grande do Norte, Brasil. Melhorando o desempenho do rastreamento de pontos de interesse em imagens através do paralelismo em GPU ................................................................................................ 90 Crystian Leão, Universidade Federal de Pernambuco, Brasil Joãoo Marcelo Teixeira, CIn ‐ UFPE, Brasil Eduardo Albuquerque, UFG, Brasil Veronica Teichrieb, Centro de Informática ‐ UFPE, Brasil Judith Kelner, CIn ‐ UFPE, Brasil. Metodologia de geração de dados de referência para rastreamentos ópticos ..................... 96 Lucas Teixeira, PUC‐Rio, Brasil Manuel Loaiza, Tecgraf ‐ Depto. de Informática, PUC‐Rio, Peru Alberto Raposo, Marcelo Gattass, PUC‐Rio, Brasil.

Fatores Humanos Chair: Fátima Nunes

Estudo Comparativo sobre a Percepção de Pistas Sonoras em Ambientes Virtuais ............. 103 Alyson Souza, Selan dos Santos, Universidade Federal do Rio Grande do Norte, Brasil. Conceitos de Presença ........................................................................................................... 109 Fernando Obana, Universidade do Estado de Mato Grosso, Brasil Romero Tori, Centro Universitário Senac / Universidade de São Paulo, Brasil. Realidade Aumentada e Publicidade: Até onde pode ir essa relação ? ............................... 113 Antonio Lutfi, Alberto Raposo, PUC‐Rio, Brasil.

xiv

Visualização Chair: Claudio Kirner Evaluating the CapCam: a device for thermal inspection of electrical equipment ............. 120 Eduardo Souza, UFPE, Brasil Luis Arthur Vasconcelos, Universidade Federal de Pernambuco, Brasil João Marcelo Teixeira, CIn ‐ UFPE, Brasil Eduardo Albuquerque, UFG, Brasil Veronica Teichrieb, Centro de Informática ‐ UFPE, Brasil Judith Kelner, CIn ‐ UFPE, Brasil. Java 3D para Sistemas de Multiprojeção utilizando Aglomerados Gráficos ...................... 126 Diego Colombo Dias, Universidade Estadual Paulista, Brasil Anthony Ferreira La marca, Universidade Paulista, Brasil Mario Popolin, UNESP, Brasil Jose Brega, UNESP ‐ Bauru, Brasil Marcelo de Paiva Guimarães, Instituto Federal de São Paulo/Faculdade Campo Limpo Paulista, Brasil José Roberto Pereira Lauris, USP, Brasil. Uma plataforma para visualização estereoscópica horizontal ............................................ 132 Bruno Madeira, Instituto Nacional de Matemática Pura e Aplicada, Brasil Luiz Velho, IMPA, Brasil.

Aplicações em Realidade Virtual e Aumentada Chair: Liliane Machado Desafios e Oportunidades da Engenharia Cognitiva na Concepção de Sistemas de Realidade Virtual e Aumentada ....................................................................................... 137 Eunice Nunes, Universidade Federal de Mato Grosso, Brasil Lucia Vilela Leite Filgueiras, Universidade de São Paulo, Brasil Fatima Nunes, EACH‐USP, Brasil Romero Tori, Centro Universitário Senac / Universidade de Sao Paulo, Brasil. Análise De Técnicas De Limiarização Adaptativa Para Realidade Aumentada Embarcada .............................................................................................................................. 143 Bernardo Reis, João Marcelo Teixeira, CIn ‐ UFPE, Brasil Eduardo Albuquerque, UFG, Brasil Veronica Teichrieb, Centro de Informática ‐ UFPE, Brasil Judith Kelner, CIn ‐ UFPE, Brasil.

xv

Utilização de Realidade Aumentada num Mapa em Suporte de Papel para a Gestão de Crises .................................................................................................................... 148 Luis Ponciano, Instituto Universitario de Lisboa, Portugal Miguel Dias, Microsoft, Portugal. PROVAR: Interface com Realidade Aumentada para Comércio Eletrônico ............................ 155 Hipólito Douglas Moreira, Universidade Federal de Itajubá, Brasil Tereza Kirner, UNIFEI, Brasil Claudio Kirner, Universidade Federal de Itajubá ‐ UNIFEI, Brasil.

Realidade Aumentada na Educação Chair: Luciana Nedel

Usando a Realidade Aumentada no Desenvolvimento de Software Educacional para Aprendizagem de Datilologia ..................................................................... 162 Cleberson Forte, Faculdade Anhanguera de Piracicaba / FATEC Americana, Brasil, Renan Andrade, Roosevelt Guedes, Marco Cavallari, Faculdade Anhanguera de Piracicaba, Brasil.

Aplicações de Realidade Aumentada para Ensino de Física no Instituto Federal de Educação, Ciência e Tecnologia de Goiás Campus Jataí ..................................................... 166 Clarissa Xavier de Camargo, Federal Institute of Education, Science and Technology of Goiás, Brasil, Vanessa Xavier de Camargo, Federal University of Goias, Brasil, Eliane Raimann, Instituto Federal de Goiás ‐ Jataí, Brasil, Italo Tiago da Cunha, Universidade Federal de Goiás, Brasil, Marcos Wagner Souza Ribeiro, Universidade Federal de Goiás ‐ Campus Jataí, Brasil. SELTRA ‐ Learning Traffic Laws by using Augmented Reality ................................................. 172 Edison Jesus, Isabela Drummond, Universidade Federal de Itajubá, Brasil. Uso de Realidade Aumentada e Reconhecimento de Voz Como Ferramenta de Apoio ao Aprendizado Para Pessoas com Dislexia ........................................................... 178 Emilia Alves Nogueira, Universidade Federal de Goias, Brasil Bruno Rocha, Rafael Tomaz Parreira, Universidade Federal de Goiás, Brasil, Thamer Horbylon Nascimento, Universidade Federal de Goiás, Brasil Vanessa Xavier de Camargo, Federal University of Goias, Brasil, Laurence Amaral, Universidade Federal de Goiás, Brasil, Marcos Wagner Souza Ribeiro, Universidade Federal de Goiás ‐ Campus Jataí, Brasil Clarissa Xavier de Camargo, Federal Institute of Education, Science and Technology of Goiás, Brasil.

xvi

Colaboração Chair: Judith Kelner Um Estudo sobre Manipulação Cooperativa em Ambientes Virtuais Colaborativos ........... 185 Paulo Paiva, Instituto Federal de Educação, Ciência e Tecnologia da Paraíba (IFPB), Brasil Liliane Machado, Universidade Federal da Paraíba, Brasil. Ambiente Virtual Colaborativo para Auxílio no Processo de Ensino‐Aprendizagem em disciplinas de Algoritmo e Programação de Computadores ....... 191 Luciana Berretta, Fabrizzio Soares, Márcio Cunha Fernandes, Universidade Federal de Goiás, Brasil Eliane Raimann, Instituto Federal de Goiás ‐ Jataí, Brasil Marcos Wagner Souza Ribeiro, Universidade Federal de Goiás ‐ Campus Jataí, Brasil On Interoperability Between Online Virtual Worlds And Augmented Reality..................... 196 Rui de Almeida, ISCTE ‐ IUL Lisboa, Portugal Miguel Dias, Microsoft, Portugal.

Realidade Virtual na Educação Chair: Edgard Lamounier

Uso de Realidade Virtual e Aumentada como Ferramenta Complementar ao Ensino das Principais Ligações entre Átomos.................................................................. 203 Dionata Araújo, Instituto Luterano de Ensino Superior ‐ ULBRA, Brasil Nayara Vieira, ULBRA/Itumbiara, Brasil. Simulador para Treinamento de Operadores de Colheitadeira Axial de Grãos .................... 209 Tales Bogoni, PUCRS, Brasil Benevid Felix da Silva, Giovane Maia do Vale, Ivan Luiz Pedroso Pires, Everton Valdomiro Pedroso Brum, UNEMAT, Brasil Marcio Pinho, Pontifícia Universidade Católica do Rio Grande do Sul, Brasil. Sistema de Ensino de Física Óptica Geométrica da Reflexão em Espelhos Usando Realidade Virtual ....................................................................................................... 214 Rafael Tomaz Parreira, Universidade Federal de Goiás, Brasil Vanessa Xavier de Camargo, Federal University of Goiás, Brasil Bruno Rocha, Universidade Federal de Goiás, Brasil Emilia Alves Nogueira, Universidade Federal de Goias, Brasil Thamer Horbylon Nascimento, Universidade Federal de Goiás, Brasil Marcelo Freitas, Universidade Federal de Goiás, Brasil Marcos Wagner Souza Ribeiro, Universidade Federal de Goiás ‐ Campus Jataí, Brasil Clarissa Xavier de Camargo, Federal Institute of Education, Science and Technology of Goiás, Brasil.

xvii

Aplicações Médicas Chair: Rosa Maria Costa

Web‐based Augmented Reality applied to upper limb simulation ........................................ 219 Jean Maurice G. Gagnepain, Kenedy Nogueira, Universidade Federal de Uberlândia, Brasil Edgard Lamounier, Alexandre Cardoso, UFU, Brasil. Visualização do Tratamento Ortodôntico Utilizando Realidade Virtual e Realidade Aumentada ............................................................................................................................... 224 Daniela Uebele, Universidade Santa Cecília, Brasil Giuliano Moraes, FATEC de Praia Grande, Brasil Alexandre Cardoso, Edgard Lamounier, UFU, Brasil. Utilização de redes neurais para a classificação de sinais EMG aplicados no controle de próteses virtuais de mão ..................................................................................... 230 Fernando Mattioli, Daniel Stefany Duarte Caetano, Wedson Gomes Edgard Lamounier, Alexandre Cardoso, UFU, Brasil. Produção de um laboratório virtual para treinamento na utilização de equipamento para captação de sinal biomédico .................................................................... 236 Marcel Nagm, Universidade Federal de Roraima, Brasil Fabio Parreira, Universidade Federal de Uberlândia, Brasil Wender Silva, Luciano Ferreira Silva, Universidade Federal de Roraima, Brasil.

Desenvolvimento Chair: Miguel Dias Modificações geométricas aplicadas a elementos reais em aplicações de RA ..................... 242 Crystian Leão, João Lima, Federal University of Pernambuco, Brasil Veronica Teichrieb, Judith Kelne, Centro de Informática ‐ UFPE, Brasil Eduardo Albuquerque, UFG, Brasil. Aplicações baseadas em Grafo de Cena‐ uma abordagem estrutural para critérios de teste .................................................................................................................................... 247 Adriano Bezerra, Marcio Delamaro, Universidade de São Paulo, Brasil Fatima Nunes, EACH‐USP, Brasil. Reconstrução de Superfícies a Partir de Pontos não‐organizados ........................................ 253 Caio Santiago, Helton Biscaro, Universidade de São Paulo, Brasil A platform for of Spatial Augmented Reality .......................................................................... 259 Julio Lucio, VISGRAF, Luiz Velho, IMPA, Brasil.

xviii

PÔSTERES

Dispositivos Hápticos: Tendências No Desenvolvimento E Limitações De Uso Para Suporte A Ambientes Autênticos De Aprendizagem ................................................... 265 Wilson M. Silva, UFPE, Brasil. Interface De Realidade Virtual Para Gerenciamento E Monitoramento De Redes ............... 267 Affonso Moia Vieira, Ingrid Aigner Ostroski, Renan Bergamin Stuchi, Bruno Monteiro Dos Santos, Flávio Yukio Nakabayashi, Raphael Zanguettin Parra, Yuri Costa Da Mata, José Ferreira Remo Brega, UNESP, Brasil. Métodos E Ferramentas Para O Desenvolvimento De Cenários De Um Sistema De Treinamento De Pilotos De Helicóptero ................................................................................ 269 Mairlo Hideyoshi Guibo Carneiro Da Luz, Alexandre Carlos Brandão Ramos, Edison Oliveira De Jesus, Felix Mora Camiño, Universidade Federal De Itajubá, Brasil. Uso Da Realidade Aumentada Como Ferramenta Auxiliar Ao Vídeo Educacional No Ensino Presencial E À Distância ............................................................................................................271 Eduardo Luis Schneider, André Grassi, Leonardo Piccoli, Daiana Vivan, Maria Isabel Timm, UFRGS, Brasil. Modelagem De Objetos Para Ambientes Virtuais Exteriores ................................................ 273 Andson Felipe Pontes Belo, Thaíse Kelly De Lima Costa, UFPE, Brasil. Proposta De Um Sistema De Realidade Aumentada Para Auxiliar No Tratamento Da Doença De Alzheimer ............................................................................................................................ 275 Keynes M. Kanno, Fábio H. M. Oliveira, Edgard A. Lamounier Jr., Alexandre Cardoso, Ederaldo J. Lopes, Universidade Federal De Uberlândia, Brasil. Implementação Em Java De Uma Estrutura De Dados Para A Representação De Malhas Elásticas Em Modelos Com Geometrias Complexas ............................................................... 277 Mariana Porlan Navarro, Helton Hideraldo Bíscaro, Fátima. L. S. Nunes, EACH‐USP, Brasil. Visualização De Estruturas Hierárquicas Por Meio De Técnicas De Realidade Virtual .......... 279 Daniel S. D. Caetano, Fernando E. R. Mattioli, Lucas P. Vasconcelos, Keynes M. Kanno, Lázaro V. O. Lima, Alexandre Cardoso, Edgard A. Lamounier Jr., Universidade Federal De Uberlândia, Brasil. Low Cost Equipment For First Person Augmented Reality Systems ...................................... 281 Christopher Shneider Cerqueira, Universidade Federal De Itajubá, Brasil.

xix

A Realidade Virtual Como Instrumento De Estudo De Concepções Espontâneas Em Dinâmica ............................................................................................................................. 283 Leandro Rezende Franco, Ruberley Rodrigues De Souza, Eliane Raimann, IFG, Campus Jataí, Brasil. A Utilização De Um Ambiente De Realidade Aumentada No Ensino Fundamental E Médio E A Difusão Da Robótica Móvel – Acesso Pela Web ..................................................................... 285 Fábio Akira Nazima, Marcelo De Souza Augusto Zanetti, Antônio Carlos Sementille, Humberto Ferasolli Filho, João Fernando Marar, UNESP, Brasil. Proposta De Arquitetura De Uma Ferramenta De Desenvolvimento De Software De Realidade Virtual Multi‐Participativo Utilizando Dispositivos Móveis Como Ferramenta De Interação ......................................................................................................... 287 Alexandre Carvalho Silva, Ligia Christine Oliveira Sousa, Marcos Wagner De Sousa Ribeiro, Universidade Federal De Goiás, Brasil. Alexandre Cardoso, Edgard Lamounier, Universidade Federal De Uberlândia, Brasil. Entendendo E Padronizando Ambientes Para Videoconferência Em Ambiente De Realidade Virtual ....................................................................................................................................... 289 Rainier A. F. Sales, PUC‐MG, Brasil. Ambiente Inteligente Para Visualização De Plantas E Maquetes 3d Baseado Em Realidade Virtual Utilizando OpenGL ....................................................................................................... 291 Alexandre Cardoso, Bruno Souto Borges, Edgard Lamounier, Hulgo Leonardo Jacinto Andrade, Marcos Wagner Souza Ribeiro, Pedro Moises, Roger Luz, Instituto Luterano De Ensino Superior De Itumbiara, Brasil. USO DA REALIDADE VIRTUAL COMO FERRAMENTA COMPLEMENTAR DE ENSINO DA GEOGRAFIA ............................................................................................................................... 293 Bruno Souto Borges, Leisson Pereira Fonseca, Pedro Moises De Sousa, Roger Armandio Luz, Vinícius Brás Feliciano, Instituto Luterano De Ensino Superior De ItumbiaraMarcos Wagner Sousa Ribeiro, Universidade Federal De Goiás, Brasil. Documentação Digital Do Patrimônio: Uma Implementação Virtual De Um Edifício Com Valor Histórico ................................................................................................................................... 295 Maria Amelia Eliseo, Ismar Frango Silveira, Fabio Silva Lopes, Beatriz A. Pacheco Fronterotta, Universidade Presbiteriana Mackenzie, Brasil. Sistemas Supervisórios Virtuais ............................................................................................. 297 Kenedy Lopes Nogueira, Keila De Fátima C. Nogueira, Gerson Flavio Mendes De Lima, Edgard A. Lamounier, Alexandre Cardoso, Universidade Federal De Uberlândia, Brasil.

xx

Panorama Atual Da Realidade Virtual E Aumentada No Brasil ........................................... 299 Luciana De Oliveira Berretta, Fabrizzio Alphonsus Alves De Melo Nunes Soares, Deborah Silva Alves Fernandes, Universidade Federal De Goiás, Brasil. Edgard Lamounier, Alexandre Cardoso E Marcos Wagner De Souza Ribeiro, Universidade Federal De Uberlândia, Brasil. Realidade Aumentada Interativa: Um Estudo De Caso Com O Ensino Do Movimento Circular ................................................................................................................ 301 Vanessa Avelino Xavier De Camargo, Bruno Moraes Rocha, Clarissa Avelino Xavier De Camargo, Emília Alves Nogueira, Rafael Tomaz Parreira, Thamer Horbylon Nascimento, Marcos Wagner De Souza Ribeiro, Joslaine Cristina Jeske De Freitas, Universidade Federal De Goiás, Campus Jataí, Brasil. Uso Da Realidade Virtual Como Ferramenta Auxiliar No Ensino Das Três Leis De Newton Da Física ...................................................................................................................... 303 Thamer Horbylon Nascimento, Bruno Moraes Rocha, Emilia Alves Nogueira, Rafael Tomaz Parreira, Vanessa Avelino Xavier De Camargo, Wanderley De Souza Alencar E Marcos Wagner De Souza Ribeiro, Universidade Federal De Goiás,Campus Jataí, Brasil. Realidade Virtual Como Apoio No Tratamento Da Siderodromofobia ................................ 305 Bruno Moraes Rocha, Emilia Alves Nogueira, Rafael Tomaz Parreira, Vanessa Avelino Xavier De Camargo, Thamer Horbylon Nascimento, Fabrizzio Alphonsus Soares De Melo Nunes E Marcos Wagner De Souza Ribeiro, Universidade Federal De Goiás, Campus Jataí, Brasil. Desenvolvimento De Uma Arquitetura Para A Distribuição De Realidade Virtual E Aumentada Aplicada Na Educação ....................................................................................... 307 Keila Nogueira, Kenedy Nogueira, Edgard A. Lamounier, Alexandre Cardoso, Universidade Federal De Uberlândia, Brasil. Uso De Realidade Virtual Como Ferramenta Complementar Ao Ensino De Problemas Matemáticos ..................................................................................................... 309 Nayara Da Silva Vieira, Dionata Martins De Araújo, Instituto Luterano De Ensino Superior De Itumbiara, Brasil. Realidade Aumentada No Marketing: Merchandising De Produtos Eletrônicos Na Web ......311 Antônio S. Veloso, Carlos Alberto C. Ramos, Elizângela S. Moreno, Jullyandry Coutinho, Pedro Ivo L. Souza, Jacquelaine A. Machado, Faculdade Atual Da Amazônia, Brasil. Wender A. Silva, Universidade Federal De Roraima, Brasil.

MENSAGEM DO PRESIDENTE DA CERV/SBC

É com imenso prazer que, em nome da Comissão Especial de Realidade Virtual da Sociedade Brasileira de Computação (CERV/SBC), apresentamos nossas mais cordiais boas vindas a todos participantes do Workshop de Realidade Virtual e Aumentada (WRVA 2010)! Este ano, o evento está em sua sétima edição e mostra de forma contundente o avanço da área no território nacional, seja no mundo acadêmico ou no mundo empresarial. Este avanço não seria concretizado sem o esforço dos profissionais de educação e pesquisa, e seus respectivos aprendizes, presentes nos laboratórios de nossas universidades. Mas, mesmo assim, sentimos que temos ainda um longo caminho a percorrer no sentido de explorar os benefícios que esta tecnologia pode proporcionar aos seres humanos. Dentre outras, esta é uma grande motivação para a realização deste encontro científico: apresentar e discutir os desafios da área para os estudantes de uma determinada região do país, a fim de identificar e capacitar os futuros profissionais a conquistar estes desafios. Portanto, gostaríamos de agradecer, profundamente, à Universidade Presbiteriana Mackenzie, São Paulo‐SP, não somente pela calorosa acolhida nas salas e corredores de sua instituição, mas também pelo suporte providenciado para a realização do workshop. Especificamente, somos muito gratos aos seus professores Luciano Silva, Beatriz Pacheco, Ismar Frango e demais colegas da Comissão Organizadora pelo grandioso trabalho, seriedade e profissionalismo dedicados ao evento, que certamente garantiram o sucesso do mesmo, confirmando assim o que alguém uma vez disse: “Que ninguém se engane só se consegue a simplicidade através de muito trabalho”. Igualmente, a CERV/SBC, reconhece e agradece ao trabalho da Comissão de Programa, liderada pelo empenho dos professores Luciano Soares e José Remo Brega pela constante preocupação em preservar a qualidade científica dos artigos a serem apresentados. Sem dúvida, são ações como estas que alavancam os ideais de ensino e pesquisa de Realidade Virtual e Realidade Aumentada em nosso país. E, certamente, providencia uma posição de destaque dos trabalhos brasileiros no cenário internacional. Finalmente, gostaríamos de deixar uma palavra para nossos estudantes. Aproveitem! Este evento foi preparado com muito carinho para você. Sucesso a todos!

Edgard Lamounier Jr.

Presidente CERV/SBC – Gestão 2010/2012

VII Workshop de Realidade Virtual e Aumentada (WRVA'2010), São Paulo(SP), 08 a 11 de Novembro de 2010

1

MENSAGEM DO COMITÊ ORGANIZADOR

As áreas de Realidade Virtual e Aumentada têm recebido, nos últimos anos, um incrível impulso não só do ponto de vista teórico quanto tecnológico. Distribuições de processamento e dados, novas formas de interação, bibliotecas e frameworks cada vez mais complexos, ubiquidade e mobilidade são alguns dos desafios que pesquisadores e estudantes enfrentam em salas de aulas e laboratórios. Assim, o incentivo à produção e intercâmbio acadêmicos e industricias devem ser práticas constantes para avanços cada vez maiores dessas áreas. Neste contexto, o Workshop de Realidade Virtual e Aumentada, em sua sétima edição, vem cumprir uma parte muito significativa desta tarefa: proporcionar interações acadêmicas e industriais nos âmbitos nacional e internacional a alunos e pesquisadores, através de mini‐cursos, palestras e apresentações de trabalhos completos e pôsteres. A Universidade Presbiteriana Mackenzie, em particular a Faculdade de Computação e Informática, tem o prazer de recebê‐los para quatro dias onde possamos aumentar a nossa rede de interação acadêmica e industrial. O conjunto de atividades foi planejado de tal forma a maximizar a acesso a todas as atividades do workshop e reflete um trabalho conjunto de inúmeros colaboradores no Brasil e no exterior. Deixamos, inicialmente, os nossos agradecimentos a CERV/SBC, nas pessoas dos professores Claudio Kirner (ex‐presidente) e Edgard Lamounier Jr. (atual presidente), pela confiança e apoio na condução deste evento. Ao comitê organizador da Universidade Mackenzie (Ismar, Ilana, Maria Amélia) pelo excelente trabalho desenvolvido. Ao comitê de programa, liderados pelo Luciano Soares e José Remo, pelo exímio trabalho condução das chamadas e revisões. Nossos agradecimentos também se estendem aos revisores, professores que ministrarão cursos, palestrantes e pesquisadores e estudantes que acreditaram no evento e enviaram suas contribuições. Agradecemos, também, ao Prof. Dr. Arnaldo Vallim, diretor da Faculdade de Computação e Informática, por todo apoio recebido. Finalmente, agradecemos ao Fundo MackPesquisa, que custeou integralmente o evento, abrindo‐nos diversos caminhos internos para resolução de questões logísticas.

Luciano Silva – Chair do Comitê Organizador Beatriz de Almeida Pacheco Fronterotta ‐ Vice‐Chair do Comitê Organizador

VII Workshop de Realidade Virtual e Aumentada (WRVA'2010), São Paulo(SP), 08 a 11 de Novembro de 2010

2

MENSAGEM DO COMITÊ DE PROGRAMA

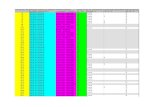

Em sua sétima edição, o Workshop de Realidade Virtual e Aumentada vem se mostrando um evento da área cada vez mais importante no cenário nacional. Desde que a CERV/SBC (Comissão Especial de Realidade Virtual da Sociedade Brasileira de Computação) optou pela união entre o Workshop de Realidade Aumentada (2004, 2005 e 2006) e o Workshop de Aplicações de Realidade Virtual (2005 e 2006), realizando o Workshop de Realidade Virtual e Aumentada (2007, 2008 e 2009), percebemos que um número crescente de pesquisadores vem participando e apresentando seus trabalhos. Nesta edição, realizada na cidade de São Paulo, diversos pesquisadores dos mais diversos cantos do Brasil e até do exterior estão presentes possibilitando a disseminação e troca de conhecimentos, além de motivar muitos estudantes para esta área. Este ano foram realizadas 71 submissões de artigos, apresentando trabalhos nas mais diversas áreas da realidade virtual e aumentada, dos quais 44 foram selecionados para artigos completos por apresentar um excelente nível de qualidade, assim tornando o evento mais inclusivo. Devido ao elevado número de submissões, tivemos que expandir o comitê de programa em quase o dobro para podermos realizar as revisões em tempo hábil. Todos os artigos sofreram pelo menos 3 revisões, o que além de garantir uma avaliação mais justa serviu como forma dos membros do comitê apontarem diversos pontos que podem ser melhorados nos artigos e na pesquisa em si. Também foram aceitos 24 pôsteres que serão apresentados durante a semana. Gostaríamos de agradecer a todo o apoio da CERV/SBC representado pelo seu presidente Edgard Lamounier, a Universidade Presbiteriana Mackenzie e comitê organizador do WRVA2010, liderado pelo Luciano Silva, além de todo o comitê de programa e revisores que fizeram um excelente trabalho. Esperamos que VII Workshop de Realidade Virtual e Aumentada seja muito proveitoso para todos os participantes e desejamos que os leitores consigam aproveitar o conteúdo aqui presente e que lhes ajudem a compreender melhor o mundo da realidade virtual e aumentada.

Luciano Pereira Soares – Chair do Comitê de Programa José Remo Ferreira Brega ‐ Vice‐Chair do Comitê de Programa

VII Workshop de Realidade Virtual e Aumentada (WRVA'2010), São Paulo(SP), 08 a 11 de Novembro de 2010

3

MINI‐CURSOS

Mini‐Curso 1: Augmented Reality: Principles and Techniques Miguel Sales Dias (Microsoft, Portugal)

In this mini course, we will address the principles and foundations of Augmented and Mixed Reality and will provide an historical perspective of this area, illustrating with an overview of the performed R&D, at the Computer Graphics and Multimedia Lab of ADETTI, in Portugal. The course will then focus in the key enabling technologies for AR, namely, presentation devices, tracking and HCI. Tracking will cover with some detail the techniques behind video‐based marker and texture tracking. HCI will focus in tangible augmented interfaces and gesture. The course will end with conclusions and open issues.

Mini‐Curso 2: Desenvolvendo Aplicações de Realidade Aumentada para a Web Cláudio Kirner (UNIFEI), Alexandre Cardoso (UFU), Edgard Lamounier (UFU), Fábio

Henrique (UFU), Pedro Cacique (UFU)

O lançamento do AS3 (ActionScript 3.0), juntamente com o ambiente de desenvolvimento Flex 2.0 e o Flash player 9.0, pela Adobe em 2006, possibilitou a evolução das aplicações RIA (Rich Internet Applications ‐ Aplicações Ricas para Internet). O desenvolvimento dessas aplicações possibilitou a criação de diversas ferramentas de apoio para a criação de aplicações de RV (Realidade Virtual) na Web, suportadas pelo FlashPlayer. Como passo seguinte, a extensão destas tecnologias proveu condições de desenvolvimento de soluções de Realidade Aumentada (RA) na Web, com a utilização de webcam e marcadores (impressos em papel comum) e da tecnologia FLARToolkit. O objetivo deste mini‐curso é apresentar tal tecnologia como ferramenta para desenvolvimento de aplicações de RA para web e apresentar alguns conceitos básicos da linguagem AS3, associado ao desenvolvimento com o FLARToolkit.

Mini‐Curso 3: RV e RA em Jogos ‐ Aplicações e Perspectivas Fátima Nunes (USP), Liliane Machado (UFPB), Rosa Costa (UERJ)

O mini‐curso mostra os principais conceitos de RV e RA aplicados ao desenvolvimento de jogos digitais, ambiente adequado para interações não‐convecionais via RV/RA. Além disto, são apresentadas perpectivas e tendências de uso de RV/RA em jogos.

VII Workshop de Realidade Virtual e Aumentada (WRVA'2010), São Paulo(SP), 08 a 11 de Novembro de 2010

4

PALESTRAS

Palestra 1 : 2014K ‐ Captação e Transmissão de Alta Definição em 3D para a Copa do Mundo de Futebol de 2014 Eunézio de Souza (Mackenzie), Jane de Almeida (Mackenzie) e Joaquim Pessoa Filho (Mackenzie) O objetivo do PROJETO 2014K é transmitir os jogos da Copa do Mundo de Futebol de 2014 no Brasil em resolução 4K/3D para cinemas de ultra‐definição através de redes fotônicas. A transmissão deverá ocorrer dentro do Brasil e do Brasil para os cinco continentes. Este é um projeto colaborativo e experimental de alta tecnologia e conta com a participação de organizações voltadas à pesquisa e inovação tecnológica, assim como do setor empresarial. Palestra 2: Interação Em Jogos: Do Joystick À Realidade Virtual Luciana Nedel (UFRGS) A palestra traz um panorama histórico da interação em jogos digitais, passando desde interações com mouse/joystick até mecanismos mais complexos de interação via RV. Jogos digitais representam um ambiente muito propício para interação não‐convencional e esquemas de RA/RV têm oferecido muitas contribuições a este contexto, tanto acadêmicas quanto industriais. Palestra 3: Realidade Virtual e Aumentada para uma Educação sem Distância Romero Tori (USP/SENAC‐SP) Desde o primeiro experimento de telepresença, realizado por Ivan Sutherland na década de 1960, a redução de distância por meio da realidade virtual e, mais recentemente, da realidade aumentada, vem se tornando cada vez mais viável e eficaz. No campo da educação, em que proximidade é essencial, tanto entre aluno e professor, quanto entre aluno e colegas e entre aluno e conteúdo, o emprego de recursos de RV e RA pode contribuir para o aumento da sensação de presença e do engajamento do aluno, não apenas em cursos a distância como também em atividades presenciais. Nesta palestra, discutiremos os conceitos de presença, distância, interatividade e flow, mostrando como podem ser trabalhados em atividades de aprendizagem, com a ajuda da RV e da RA, para se chegar a uma “educação sem distância”.

VII Workshop de Realidade Virtual e Aumentada (WRVA'2010), São Paulo(SP), 08 a 11 de Novembro de 2010

5

TRABALHOS COMPLETOS

Full Papers

VII Workshop de Realidade Virtual e Aumentada (WRVA'2010), São Paulo(SP), 08 a 11 de Novembro de 2010

6

SESSÃO TÉCNICA 1

JOGOS EM REALIDADE VIRTUAL E

AUMENTADA

VII Workshop de Realidade Virtual e Aumentada (WRVA'2010), São Paulo(SP), 08 a 11 de Novembro de 2010

7

Uma Arquitetura para Integração de Sistemas Hápticos e Engines de Jogos

Herbet Ferreira Rodrigues e Liliane dos Santos Machado

Laboratório de Tecnologias para o Ensino Virtual e Estatística - LabTEVE

Universidade Federal da Paraíba – UFPB

Cidade Universitária s/n – 58051-900 – João Pessoa – PB – Brasil

{herbet, liliane}@di.ufpb.br

Resumo

O sentido do tato e a interação física estão entre os

aspectos fundamentais em que o ser humano precisa

para compreender o mundo e provocar mudanças

nele. Para os jogos, os sistemas hápticos podem

oferecer um conceito de interação de forma avançada,

ampliando o nível de realismo e oferecendo uma maior

imersão no ambiente virtual. Este artigo apresenta um

estudo, um planejamento e o desenvolvimento de uma

arquitetura para integrar uma engine de jogos com

sistemas hápticos.

Abstract

The sense of touch and physical interaction are

among the fundamental aspects that human being

needs to understand the world and cause changes to it.

For games, haptic systems can offer a concept of

interaction in a sophisticated way, increasing the level

of realism and offering greater immersion in the

virtual environment. This paper presents a study, a

planning and development of an architecture to

integrate a game engine with haptic systems.

1. Introdução

Os serious games vêm sendo utilizados para

identificar jogos com um propósito específico, ou seja,

que extrapolam a ideia de entretenimento e oferecem

outros tipos de experiências, como às voltadas ao

aprendizado e treinamento [13]. Estes jogos permitem

aos jogadores experimentarem tarefas e atividades que

poderiam ser difíceis de realizar repetidas vezes sejam

pelo seu alto custo, tempo, logística ou por razões de

segurança [5]. De acordo com Rankin e Sampayo [17]

estes jogos estão sendo aplicados em diversas áreas do

conhecimento, tais como militar, empresarial,

governamental, política, religião e artes. Entretanto, um

dos setores que tem mais se beneficiado do uso dos

serious games, principalmente com a combinação de

treinamento e ensino, é o da saúde [12]. Para os serious

games com este foco, os mesmos devem fornecer um

excelente grau de realismo a fim de que o jogador

possa interagir com o ambiente do mesmo modo que o

faz em situações reais. Além de um sistema de

visualização eficiente, é importante incluir um sistema

de interação que permita que o jogador possa sentir os

objetos virtuais no ambiente. Este tipo de interação é

chamado de interação háptica e ocorre através de um

dispositivo que reflete força, permitindo que um

jogador toque, sinta e manipule os objetos 3D da cena.

Aliado à Realidade Virtual (RV), o

desenvolvimento dos serious games em ambientes

imersivos com a inclusão de dispositivos hápticos,

podem contribuir para a motivação e aprendizado do

jogador. A incorporação de um dispositivo háptico

possibilitaria ampliar o nível de realismo e oferecer

uma forma mais eficiente de envolvimento, trazendo

melhores resultados na realização das atividades de

natureza tátil inseridas nos jogos. Diversos projetos de

RV têm comprovado que a utilização de dispositivos

hápticos em aplicações na saúde, para a educação e

treinamento, melhora o nível de percepção e

aprendizado efetivo ampliando a sensação de imersão

sentida pelo usuário [10]. Entretanto, poucos são os

incentivos da aplicação destes dispositivos em serious

games.

A partir da proposta de Rodrigues et al. [18] cujo

objetivo é o desenvolvimento de um serious game

relacionado ao treinamento e educação para a higiene

bucal de adultos utilizando um dispositivo háptico

como forma de interação, este artigo traz como

contribuição o estudo e as etapas de planejamento,

integração e desenvolvimento dos módulos gráfico,

físico e háptico do jogo proposto. Os demais elementos

que fazem parte do desenvolvimento do serious game

como roteiro, conceituação artística, jogabilidade,

inteligência, interface, entre outros, não serão

abordados neste artigo.

VII Workshop de Realidade Virtual e Aumentada (WRVA'2010), São Paulo(SP), 08 a 11 de Novembro de 2010

8

2. Sistemas Hápticos

A computação tem fornecido informações para os

sentidos humanos da visão e da audição, como

também, sistemas de áudio e vídeo têm sido

aperfeiçoados por muitas décadas. Mas recentemente, o

aumento na capacidade do computador e o desejo de

criar melhores formas de interagir com mundos virtuais

gerados por computador têm levado ao

desenvolvimento de sistemas que permitam a inclusão

do sentido do tato [11].

A percepção do toque está relacionada a duas

componentes: tato e cinestesia. O tato permite

identificar sensações como temperatura, pressão ou

vibrações e depende da sensibilidade cutânea. Esta

sensibilidade varia de acordo com a região utilizada

para realizar o contato. A cinestesia, por sua vez,

refere-se à percepção das tensões aplicadas aos

músculos e juntas. Esta percepção é também chamada

de propriocepção ou force-feedback (retorno de força)

[3] e permite identificar a rigidez de objetos.

Em sistemas computacionais, a identificação do tato

e de retorno de força depende de duas partes

igualmente importantes que formam os sistemas

hápticos: os dispositivos, responsáveis por receber

ações do usuário e apresentar-lhe as propriedades

relacionadas ao toque, e as rotinas de controle,

responsáveis por calcular e enviar as propriedades do

toque ao dispositivo.

Atualmente os dispositivos hápticos disponíveis

variam em sofisticação e fidelidade. Em um extremo

estão os gamepads com vibração e os joysticks com

retorno de força que oferecem interatividade limitada

[11]. No outro extremo se encontram os dispositivos

hápticos mais sofisticados como o PHANToM Omni

(Figura 1) da SensAble Technologies Inc. [19] e o

Falcon da Novint Technologies Inc. [21] que oferecem

um maior nível de interatividade, pois permitem até 6

graus de liberdade em movimentos de posição/rotação

e 3 graus de liberdade em retorno de força para o

usuário.

Figura 1. Dispositivo Háptico PHANToM Omni da

SensAble Technologies Inc.

3. Sistemas Hápticos em Jogos

De acordo com Chang et al. [6], tecnologias

hápticas passarão a fazer parte integrante do processo

de design de jogos, exigindo um planejamento criativo

a fim de aproveitar ao máximo esta tecnologia. Os

hábitos dos jogadores também poderão mudar a fim de

incorporar o sentido do tato, o que lhes darão uma

interação mais complexa com o ambiente do jogo,

ampliando a imersão e tornando o processo de

entendimento de tomada de decisão mais completo.

Jones [11] afirma que o aumento dos jogos com

sistemas hápticos, em que os alunos se tornam

participantes ativos no ambiente, representa uma das

mais interessantes inovações na concepção de ensino e

aprendizagem baseados por computador dos últimos

anos.

Como exemplo de jogos que utilizam um

dispositivo háptico como forma de interação, pode-se

destacar o HaptiCast [1], um jogo 3D multiplayer que

coloca os jogadores em um ambiente de primeira

pessoa. Ele é projetado para proporcionar ação e um

alto nível de interatividade utilizando o dispositivo

háptico PHANToM Omni. No HapiCast, o jogador se

torna um bruxo e tem disponível alguns tipos de

varinhas mágicas. Quando o jogador usa uma varinha,

é lançado um feitiço que exibe um efeito háptico, o

qual oferece uma maneira diferente de interagir com o

ambiente. O jogo também simula a sensação de arrastar

objetos pesados, gravidade e forças de impulso

provocado por colisões entre objetos.

Outro exemplo de jogo encontrado na literatura é o

Haptic Battle Pong [14], uma versão do jogo Pong

com suporte a dispositivo háptico. Nele, o retorno de

força proporcionado pelo dispositivo é utilizado para

mostrar o contato entre a bola e a raquete do jogador.

No entanto, os efeitos hápticos apresentados são

limitados, não utilizando todo potencial que um

dispositivo háptico pode oferecer.

O HapticCycle [7], é um jogo 3D que consiste em

uma bicicleta inserida no contexto de um jogo de

triciclos e integrada a um dispositivo de interação

háptico. O retorno háptico fornecido pela aplicação

ocorre pela simulação de resistência de acordo com o

relevo de um terreno, percebida no ato de pedalar a

bicicleta. Através dos resultados da avaliação feita

pelos desenvolvedores do HapticCycle, foi concluído

que a inclusão de uma resposta háptica na aplicação 3D

de corrida de triciclos contribuiu de forma significativa

para um aumento no nível de atratividade e diversão do

jogador, ampliando sua imersão na aplicação.

De acordo com as pesquisas realizadas e os

trabalhos mencionados acima, observa-se que ainda são

VII Workshop de Realidade Virtual e Aumentada (WRVA'2010), São Paulo(SP), 08 a 11 de Novembro de 2010

9

poucas as iniciativas voltadas para o uso de serious

games com foco em treinamento e ensino com a

utilização de sistemas hápticos. Dessa forma, torna-se

relevante o estudo e investigação em relação à

aplicabilidade dos sistemas hápticos como forma de

interação em serious games.

4. Integração de Dispositivos Hápticos em

Jogos

Farias et al. [7] analisa que para a construção de um

jogo deve-se adotar um modelo de desenvolvimento

rápido e eficiente, devido à crescente rapidez com a

qual novos jogos e tecnologias chegam no mercado. E

para alcançar este objetivo, foram criados os motores

de jogos ou game engines.

As game engines de jogos tem sido constantemente

utilizadas por oferecerem gerenciamento do cenário,

animação de personagens, iluminação, fluxo do código

e suporte a diferentes plataformas [12]. Entretanto,

Farias et al. [7] e Machado et al. [12] explicam que um

problema existente na utilização destas engines é que o

desenvolvedor limita-se às mesmas formas de interação

convencionais como joysticks, não havendo um suporte

genérico a dispositivos com características diferentes

como os dispositivos hápticos, por exemplo.

Neste ponto, observa-se que para que ocorra a

comunicação entre uma engine e dispositivos hápticos

é necessário o uso de programas específicos ou APIs

(Application Programming Interface). Geralmente,

cada dispositivo possui um programa ou API própria

para sua programação.

Há alguns trabalhos sobre a integração de sistemas

hápticos em motores de jogos. Nilsson e Aamisepp

[16] explicam da importância de incorporar o háptico

em um motor 3D e um plug-in para a engine Crystal

Space foi desenvolvido para demonstrar esta

integração. No entanto, os processos e detalhes sobre a

integração não foram bem exploradas por este projeto.

Existem outros esforços [4] para combinar

renderização gráfica e sistemas hápticos, mas estes não

contêm características que são desejáveis para o

desenvolvimento de jogos, como mecanismos de

inteligência artificial e controles de estados, por

exemplo.

Outro componente importante no desenvolvimento

de jogos com sistemas hápticos é o motor de física ou

physics engine, que simula a física para todos os

objetos no ambiente virtual do jogo. Variáveis tais

como massa, velocidade, inércia, fricção e forças

externas, contribuem para o realismo do jogo. Este

componente fornece detecção de colisões e resposta

entre objetos, permitindo que os jogadores percebam

uma dinâmica física, bem como o acesso à informação

utilizada pelos algoritmos de renderização de forças

para os dispositivos hápticos.

5. Proposta de Integração

A partir do estudo realizado e da necessidade de

desenvolver um serious game com interação háptica

para saúde com foco em treinamento e ensino é

proposto um conjunto de módulos e classes para a

integração entre sistemas hápticos e uma engine de

jogos.

Um jogo com retorno háptico deve considerar

quatro fatores para a sua implementação [2]. Esses

fatores são: a posição e orientação do jogador no

mundo virtual, a detecção de colisão do jogador com o

objeto virtual e a reação da colisão, que é transmitida

ao usuário através de dispositivos hápticos. A Figura 2

mostra como funciona a interação de um jogador com o

ambiente virtual do jogo.

Figura 2. Esquema de interação de um jogo com

dispositivo háptico.

Portanto para o desenvolvimento de rotinas para

incorporação do toque em jogos é necessária à criação

de classes para a interação háptica, para as colisões

físicas e para a visualização de todos os

comportamentos resultantes destas colisões na cena

gráfica.

5.1 O Módulo Gráfico

O módulo gráfico é responsável pela renderização

da cena 3D visual e exibição da interface gráfica para o

usuário.

A engine gráfica escolhida para o projeto foi a

Irrlicht [9], uma engine 3D rápida, multiplataforma e

que inclui recursos como sombreamento, z-buffering,

iluminação dinâmica, carregadores de malha, sistemas

de partículas, texturização, entre outros. Esta engine é

VII Workshop de Realidade Virtual e Aumentada (WRVA'2010), São Paulo(SP), 08 a 11 de Novembro de 2010

10

responsável por exibir os objetos 3D na tela, bem como

a interface gráfica do usuário.

5.2 O Módulo Físico

A engine de física escolhida para o jogo é a Newton

Game Dynamics [15], que é uma engine de física

simples com desenvolvimento em C/C++. Cada objeto

do mundo do jogo tem uma representação física e,

portanto, é capaz de exibir um comportamento físico

realista em tempo-real.

Este módulo será responsável pela identificação das

colisões ocorridas no ambiente. Estas colisões devem

ocorrer não apenas entre objetos gráficos, mas também

entre eles e objetos hápticos. Deste modo, o módulo

fornecerá as variáveis relacionadas ao ponto e

momento da colisão.

5.3 O Módulo Háptico

Neste projeto está sendo utilizado a dispositivo

háptico PHANToM Omni da SensAble Technologies.

Este dispositivo foi selecionado por possuir as

características adequadas para simulações e jogos de

destreza manual. Para a utilização do PHANToM

Omni, existe o pacote chamado OpenHaptics Toolkit

[20] que oferece suporte ao dispositivo.

O OpenHaptics Toolkit é desenvolvida nos mesmos

moldes da API OpenGL, sendo familiar aos

programadores gráficos e facilita a integração com as

aplicações OpenGL e engines existentes. A

OpenHaptics é composta de duas camadas: a API do

dispositivo háptico (HDAPI) e a API da biblioteca

háptica (HLAPI). A HDAPI fornece acesso de baixo

nível ao dispositivo háptico. Já a HLAPI fornece

acesso de mais alto nível para a programação do

dispositivo, facilitando a atribuição das propriedades

hápticas. Ela permite significante reuso de código

existente no OpenGL e simplifica a sincronização dos

processos hápticos e gráficos. [20]. Embora a técnica

de renderização de força na cena gráfica pela HLAPI é

amplamente utilizada, apenas a HDAPI está sendo

usada no jogo devido à sua flexibilidade em produzir

vários efeitos de força e a sua independência com as

engines gráficas.

5.4 Arquitetura Proposta

A arquitetura em alto nível do jogo e os módulos

principais descritos anteriormente é mostrada na Figura

3. A camada central – chamada de Framework – possui

os módulos Gráfico, Físico e Háptico, no qual contem

todas as classes necessárias para a inicialização da cena

gráfica, inicialização do dispositivo háptico, geração

dos objetos e suas características físicas, como

também, o controle de posições, colisões e forças que

serão utilizados pela camada Lógica do jogo (camada

superior).

Figura 3. Arquitetura proposta em alto nível.

Para o jogo proposto [18] foi criado um conjunto de

classes. A classe Main inicializa a engine gráfica e

possui o loop principal do jogo. A classe

GameManager adiciona todos os objetos que farão

parte da cena do jogo, como também suas posições. A

classe Object define todas as variáveis e métodos

necessários para a interação dos objetos na cena. Já as

classes Physics e Haptics representam os módulos

Físico e Háptico. A classe Player, uma das principais

classes do jogo, representa o dispositivo háptico na

cena do jogo. A Figura 4 mostra o Diagrama de Classes

em alto nível das classes criadas para esta integração.

Figura 4. Diagrama de classes do jogo.

VII Workshop de Realidade Virtual e Aumentada (WRVA'2010), São Paulo(SP), 08 a 11 de Novembro de 2010

11

A seguir será descrito com mais detalhes algumas

das principais funcionalidades que a classe Player

fornece para o restante da arquitetura.

5.5 A classe Player

A HDAPI requer que o desenvolvedor maneje

diretamente a renderização da força para o dispositivo

háptico [20]. Para prover renderização direta da força

são requeridos algoritmos para detecção de colisão e

estruturas de dados eficientes devido à alta necessidade

de atualização para estabilizar o laço de controle do

dispositivo háptico. Um problema de usar uma engine

física com a HDAPI é que as forças que atuam sobre

um objeto, necessárias para calcular a força de retorno

sobre os dispositivos hápticos, não são acessíveis

diretamente. A classe Player foi proposta para evitar

estes tipos de problemas, permitindo calcular os

retornos de força com os dados geométricos fornecidos

pelo Módulo Físico, como também, o envio das forças

para o dispositivo háptico via HDAPI.

A classe recebe a posição do dispositivo háptico e

transforma esta posição na posição do objeto

representado pelo dispositivo na cena gráfica. As

colisões detectadas pelo Módulo Físico são passadas

para a classe Player para calcular a força resultante e

enviar para o dispositivo háptico.

A Figura 6 ilustra de forma resumida o fluxo de

dados entre a classe Player e os Módulos Físico e

Háptico. Neste caso particular, a engine física funciona

em 60Hz enquanto a interface háptica é executado de

forma assíncrona em 1000Hz.

Figura 6. Fluxo de dados entre os Módulos Físico e

Háptico pela classe Player.

Pelo módulo Háptico, a posição do dispositivo é

atualizada a cada loop da HDAPI. A posição do

dispositivo pode ser obtida usando a função

“hdGetDoublev” com um dos seguintes parâmetros:

HD_CURRENT_POSITION ou

HD_CURRENT_TRANSFORM. Novamente pelo

módulo Háptico, a força pode ser enviada para o

dispositivo usando a função “hdSetDoublev” com o

parâmetro HD_CURRENT_FORCE.

No Módulo Físico, as colisões são interceptadas

usando a função “NewtonCollisionCollide”. Sempre

que uma colisão é detectada em um objeto, a função irá

retornar algumas informações sobre a colisão, como o

ponto de contato, o vetor normal e a distância de

penetração de um objeto com o outro, no qual estas

informações são utilizadas para calcular o retorno de

força resultante.

5.6 Renderização das Forças

Há vários modos de se computar as forças que são

produzidas pelo dispositivo háptico. Algumas das mais

interessantes forças de interação consideram o finalizar

do dispositivo (ponta do braço articulado que o usuário

segura nas mãos) e seu relacionamento com os objetos

no ambiente do jogo.

O vetor força é a unidade de saída do dispositivo

háptico. Há vários modos de computar força para gerar

uma variedade de sensações. Há três classes principais

de forças que podem ser simuladas: dependente do

movimento, dependente do tempo, ou uma combinação

de ambos [2].

As forças dependentes do movimento são

computadas baseadas nos movimentos do dispositivo

háptico [2]. Algumas delas são:

Elasticidade: a força de elasticidade é a mais

comum. Ela pode ser computada pela lei de

Hooke: F = k * x, onde k é a constante de rigidez e

x é o vetor de deslocamento.

Amortecedora: a principal utilidade da força

amortecedora é reduzir as vibrações, opondo-se ao

movimento. Ela é proporcional a velocidade do

finalizar do dispositivo. A equação padrão para

seu cálculo é F = - b * v, onde b é a constante de

amortecimento e v é a velocidade do finalizador.

As forças dependentes do tempo, como o próprio

nome já diz, são forças computadas com uma função

dependente do tempo [2]. Algumas delas são:

Constante: a força constante é uma força com

magnitude e direção fixa.

Periódica: a força periódica é um padrão que se

repete em um intervalo de tempo, tendo um

período e uma amplitude que determina a potência

da força.

Impulsiva: é uma força que é instantaneamente

aplicada e na prática, com o dispositivo háptico,

atua em pequeno intervalo de tempo.

A partir das informações destes dois tipos de classes

de forças, podem-se criar os algoritmos que resultarão

VII Workshop de Realidade Virtual e Aumentada (WRVA'2010), São Paulo(SP), 08 a 11 de Novembro de 2010

12

na sensação que o jogador irá sentir no dispositivo

háptico durante o jogo.

6. Considerações Finais

Toque e interação física estão entre os aspectos

fundamentais em que o ser humano precisa para

compreender o mundo e provocar mudanças nele [8].

Os sistemas hápticos permitem oferecer um conceito de

interação avançada para jogos, ampliando o grau de

realismo da aplicação.

Neste artigo foi apresentado um estudo, o

planejamento e a definição de uma arquitetura para

integrar sistemas hápticos e engines de jogos com o

objetivo de permitir o desenvolvimento de um serious

game voltado ao ensino e treinamento em saúde.

Atualmente o projeto se encontra na fase de

implementação dos algoritmos de renderização de

retorno de forças para o dispositivo háptico. A

integração do dispositivo à engine já foi realizada de

modo a permitir visualizar os movimentos do mesmo

no ambiente do jogo.

7. Agradecimentos

Este projeto é financiado pelo CNPq através do

processo 133693/2009-0.

8. Referências [1] Andrews, S., “HaptiCast: A Physically Based 3D Game

with Haptic Feedback”, Emerging Input/Output in Games,

Futureplay, Canada, 2006.

[2] Basdogan, C., Srinivasan, M.A., “Haptic Rendering In

Virtual Environments”,Virtual Environments HandBook, Ed:

K.M. Stanney, Publisher: Lawrence Erlbaum Associates,

2001, pp. 117-134.

[3] Burdea, G., Coiffet, P., “Virtual Reality Technology”,

Wiley-Interscience, 2003.

[4] Conti F., Barbagli F., Morris D., Sewell C., “CHAI:An

Open-Source Library for the Rapid Development of Haptic

Scenes”, Demo paper presented at IEEE World Haptics, Pisa,

Italy.March 2005.

[5] Corti, K., “Games-based Learning: A Serious Business

Application”.

http://www.pixelearning.com/docs/seriousgamesbusine

ssapplications.pdf., 2006. Acesso em agosto de 2010.

[6] Chang, D., “Haptics: Gaming's New Sensation”,

Computer, Volume 35, Issue 8, 2002, pp. 84-86.

[7] Farias, T., Silva, D., Moura, G., Teixeira, J. M., Costa, L.

H., Dias, G. Teichrieb, V., Kelner, J., “Um Estudo de Caso

sobre a Construção e a Integração de Dispositivos Hápticos

com Aplicações Interativas”, Anais do Simpósio Brasileiro

de Jogos de Computador e Entretenimento Digital

(SBGAMES 2006), Vol. 2006. Recife – PE, 2006.

[8] Faust, M.; Yoo, Yong-Ho., “Haptic Feedback in

Pervasive Games”, Pervasive Gaming Workshop at

Pervasive, Ireland, 2006.

[9] Irrlicht Engine, http://irrlicht.sourceforge.net/. Acesso

em agosto de 2010.

[10] Jones, M.G., Bokinsky, A., Tretter, T.; Negishi. A., “A

Comparison of Learning with Haptic and Visual Modalities”,

Haptics-e 3.6, 2005.

[11] Jones, M. G., “Getting a "Feel" for Serious Games”, In

L.A. Annetta (Ed.), Serious educational games. Rotterdam,

The Netherlands: Sense Publishing, 2008, pp. 73-81.

[12] Machado, L.S.; Moraes, R.M.; Nunes, F., “Serious

Games para Saúde e Treinamento Imersivo”, Book Chapter.

In: Abordagens Práticas de Realidade Virtual e Aumentada.

Porto Alegre: SBC, 2009, pp. 31-60.

[13] Michael, D., Chen, S., “Serious Games: Games That

Educate”, Train and Inform. Course Technology PTR, 2005.

[14] Morris, D., Neel, J., and Salisbury, K., “Haptic Battle

Pong: High-Degree-of-Freedom Haptics in a Multiplayer

Gaming Environment”, Experimental Gameplay Workshop,

GDC, 2004.

[15] Newton Dynamics Game Engine.

http://www.newtondynamics.com/. Acesso em agosto de

2010.

[16] Nilsson, D., and Aamisepp, H., “Haptic Hardware

Support in a 3D Game Engine”, Master thesis, Department of

Computer Science, Lund University, May 2003.

[17] Rankin, J.R., Sampayo S., “A Review of Serious Games

and Other Game Categories for Education”, SimTect 2008,

Melbourne, Australia, 2008, pp. 305-311.

[18] Rodrigues, H. F., Machado, L. S., Valença, A. M. G.,

“Uma Proposta de Serious Game Aplicado à Educação em

Saúde Bucal”, In: anais do Workshop de Realidade Virtual e

Aumentada, Santos, Brazil, CDROM, 2009.

[19] SensAble Technologies Inc., http://www.sensable.com/.

Acesso em agosto de 2010.

[20] SensAble Technologies, Programmer’s Guide 3D Touch

SDK OpenHaptics Toolkit. Versão 3.0, 2009.

[21] Novint Technologies Inc., http://www.novint.com/.

Acesso em agosto de 2010.

VII Workshop de Realidade Virtual e Aumentada (WRVA'2010), São Paulo(SP), 08 a 11 de Novembro de 2010

13

Analise de um Sistema de Interacao Tangıvel 3D para Jogos com RealidadeAumentada

Daniel M. Tokunaga, Silvio R. R. Sanches, Fernando Tsuda, Ricardo Nakamura, Romero ToriInterlab – Laboratorio de Tecnologias InterativasEscola Politecnica da Universidade de Sao Paulo

Abstract

This paper presents an analysis of a system for tangi-ble interface based on computer vision that allows the userto specify position and orientation informations in a natu-ral way. Our system is characterized by presenting stabilityand robustness in relation to different manipulations of theusers. Additionally, in applications based on AugmentedReality the device can be used for the registration of virtualobjects, increasing the sense of presence by the illusion ofdirect manipulation of it. A game based on Augmented Rea-lity was developed to evaluate this system, either due to thecharacteristics of tangible interface, or the fact that gamesare suitable for the testing of new interactive technologies.We intend that interaction techniques can be studied fromthe proposed solution, as well as other applications of thesame.

1 Introducao

Interfaces nao convencionais tem se mostrado um re-curso cada vez mais comum em pesquisas industriais eacademicas que exploram o uso de tecnologia e tecnicas deinteracao em jogos eletronicos. Exemplos a serem citadossao os sistemas GuitarHero, EyeToy e Wii.

Em jogos de Realidade Aumentada (RA), que combinamelementos reais com objetos virtuais para representar perso-nagens e compor o cenario do jogo, uma forma de interacaoalternativa pode ser desejavel. Em um ambiente no qual ojogador pode visualizar sua propria imagem como um ele-mento do jogo, por exemplo, a interacao feita por meio dedispositivos convencionais pode ter um aspecto pouco moti-vador se comparada a uma interface que explore movimen-tos mais naturais (como golpear um objeto com as maos ouesquivar-se dele).

Neste contexto, o presente trabalho apresenta umaanalise de um sistema de interface tangıvel baseado emvisao computacional, cujo objetivo e servir de base para

futuros estudos de tecnicas de interacao, aplicadas, inici-almente, em jogos eletronicos de RA, mas que pode ter suautilizacao estendida para aplicacoes de outros domınios.

2 Interfaces Tangıveis em Jogos com Reali-dade Aumentada

O conceito de interface tangıvel consiste na relacao me-taforica direta de um objeto fısico com um objeto virtual,de forma que a movimentacao de um deles (normalmenteo fısico) seja reproduzida pelo objeto virtual ao qual se co-necta, i.e., utiliza-se interacoes com o mundo real (no caso,o cubo real mostrado na Figura 2) como metafora para ainformacao manipulada no ambiente virtual (um campo deforca em forma de cubo que envolve a nave, modelado parao prototipo descrito na secao 6.2) [8].

A combinacao de um sistema de RA com interface deusuario tangıvel e chamada Tangible Augmented Reality(TAR) [4]. Por meio de uma TAR, objetos reais podem serutilizados para manipulacao de elementos dentro de ambi-entes virtuais, ainda que o usuario nao seja treinado parapraticar tecnicas convencionais de interacao 3D [3].

Segundo Kato et al [9], a utilizacao de interfacestangıveis em sistemas de RA pode trazer benefıcios aousuario devido as propriedades fısicas dos objetos, que po-dem ser usadas para sugerir como o objeto virtual associ-ado ao objeto real se comporta. Essas propriedades tambemrestringem o modo como esses objetos podem ser manipu-lados.

Tarefas de manipulacao em sistemas imersivos, porexemplo, tem seu desempenho aumentado quando se uti-lizam TARs [9], alem do fato de os objetos poderem sertocados tambem contribuir para o aumento da sensacao depresenca em ambientes virtuais ou aumentados [7] e, con-sequentemente, em jogos que utilizem essas tecnologias.

Muitos trabalhos envolvendo TARs aplicadas a jogos po-dem ser encontrados na literatura. Entre os projetos quepodem ser destacados, encontra-se o trabalho de Starner etal. [11], que consiste em um jogo multi-player no qual os

VII Workshop de Realidade Virtual e Aumentada (WRVA'2010), São Paulo(SP), 08 a 11 de Novembro de 2010

14

jogadores podem utilizar uma TAR baseada em visao com-putacional para reconhecer objetos do jogo. Outro exemplode utilizacao de TAR baseada em visao computacional e oprojeto MonkeyBridge [2]. O sistema e um jogo colabora-tivo de RA cuja interacao e feita, entre outras formas, pormeio de marcadores fiduciais.

O Jumanji Singapore [14], executado em um ambientede RA, consiste em um ambiente no qual jogadores podemse movimentar entre o mundo real, aumentado e virtual.Marcadores fiduciais manuseados pelo usuario e a forma dedirecionar a movimentacao do personagem no jogo.

Outro trabalho a ser destacado, voltado ao ensino de sig-nificados de sımbolos, foi apresentado por Wagner e Bara-konyi [12]. Os autores propuseram um jogo em ambientede RA que tambem utiliza TAR por meio de marcadoresfiduciais como forma de interacao. Uma extensa lista detrabalhos envolvendo jogos de RA que exploram diferentestecnologias de interfaces tangıveis pode ser encontrada emBernardes et al. [3].

3 Problemas

Uma das principais dificuldades na utilizacao de tecnicasde visao computacional para rastrear objetos – e obter suaposicao e orientacao – e contornar o problema da oclusao(perda de visibilidade do marcador).

A nao identificacao do objeto (ou marcador, no caso dasolucao proposta) pode ser provocada por diversos moti-vos como: posicionamento das maos do usuario, que cobreparte da marca; distancia do objeto em relacao a camera;iluminacao insuficiente ou mal distribuıda no ambiente; oupouca qualidade do dispositivo de captura. Como con-sequencia, acoes dentro do jogo – como movimentacao depersonagens – podem ser interrompidas.

Alem dos problemas citados, fatores mais sutis surgemcomo empecilhos a aplicacao de tecnicas desse tipo. Bibli-otecas de software que se baseiam em marcadores fiduci-ais [6, 5, 13], por exemplo, estimam posicao e orientacaodessas marcas com precisao e desempenhos aceitaveis paragrande parte das aplicacoes. No entanto, essas ferramentasainda se mostram instaveis, pois suas funcoes retornam di-ferentes valores de coordenadas mesmo quando o marcadorreconhecido nao e movimentado. No contexto de um jogo,tal instabilidade pode ser suficiente para causar prejuızo aojogador. O ultimo problema citado e tratado no presentetrabalho.

Uma analise do processo de deteccao do ARToolkit [6],uma das bibliotecas mais conhecidas, pode ser encontradano trabalho de Abawi et al. [1]. Sua precisao, exibidacomo uma funcao da distancia da camera em relacao ao seuangulo de rotacao no eixo Y , pode ser visualizada na Figura1.

Como pode ser observado, os resultados obtidos pelos

Figura 1. Precisao do processo de deteccaodo ARTookit, como uma funcao da distanciada camera em relacao ao seu angulo derotacao no eixo Y.

autores mostram que os erros sistematicos do ARToolkit,em relacao a distancia do marcador na faixa entre 20 e 70cm sao baixos e o desvio padrao entre 20 e 50 cm e pe-queno. Em relacao aos angulos de rotacao no eixo Y , oserros sistematicos sao menores na faixa entre 30◦ e 40◦, e odesvio padrao e pequeno na faixa entre 40◦ e 85◦.

4 Solucao Proposta e Desenvolvimento doSistema

Como forma de minimizar os problemas citados e de tor-nar a solucao utilizavel em jogos eletronicos, o sistema de-senvolvido faz uso de varios marcadores fiduciais com o ob-jetivo de aumentar a estabilidade no processo de reconheci-mento. Seis diferentes marcas, correspondentes a cada facedo cubo mostrado na Figura 2, sao utilizadas.

A aplicacao de marcadores fiduciais nas faces de umcubo e uma estrategia que tem sido bastante explorada emsistemas baseados em visao computacional. Grande partedesses sistemas utiliza esse recurso para obter redundancia(mais de uma marca associada a um unico objeto) e, as-sim, minimizar a interrupcao do processo de obtencao dascoordenadas nas quais um objeto virtual sera inserido [10].

VII Workshop de Realidade Virtual e Aumentada (WRVA'2010), São Paulo(SP), 08 a 11 de Novembro de 2010

15

Figura 2. Marcadores fiduciais aplicados so-bre cada face do cubo (seis marcadores).

No sistema desenvolvido, as coordenadas de todas as facesvisıveis colaboram para sua estabilidade.

A matriz de transformacao (dados de posicao e rotacao)do cubo e obtida a cada quadro de vıdeo pelo calculo damedia das matrizes de transformacao de cada marcador fi-ducial, fazendo com que os valores finais sofram meno-res variacoes quando comparados aos valores de posicaoe rotacao obtidas de um unico marcador. Para que issoaconteca, o sistema e configurado de modo que o centro –posicao (0, 0, 0) – de cada marcador representem a mesmaposicao, o centro do cubo. Consequentemente, os eixos (X,Y e Z) dos marcadores visıveis representam um unico sis-tema de coordenadas, como mostrado na Figura 3.

Figura 3. Media das rotacoes dos marcadoresvisıveis e utilizada para obter a orientacao.

Devido a caracterıstica fısica do cubo, uma, duas ou tresfaces podem estar visıveis a camera em determinado quadrode vıdeo. Quanto maior o numero de faces visıveis, maiorestabilidade e alcancada, pois as orientacoes das marcas emrelacao a camera, alem de serem as mais proximas a ideal(Figura 1), podem ser utilizadas no calculo.

5 Testes Realizados

Como forma de validar o sistema, foram realizados tes-tes para verificacao a precisao e desempenho da interface.Para isso, o prototipo desenvolvido, que sera detalhado nasecao 6.2, foi modificado para possibilitar o registro das co-ordenadas necessarias para os calculos.

Para realizacao dos testes foi montado um ambiente quepermitisse a medicao da estabilidade e o desempenho demaneira controlada e com repetibilidade. Foram tomadoscuidados com o posicionamento da camera e do cubo, como controle da iluminacao do ambiente e com caracterısticasdo dispositivo de captura, como compensacao automaticade iluminacao. Fatores como esses poderiam influenciaro resultados dos testes. O cubo foi fixado a distancia de40 cm da camera de vıdeo, ambos fixados em tripes, comomostrado na Figura 4.

Foram capturados em torno de 600 quadros comresolucao 640x480 pixels para cada bateria de testes, a umataxa de aproximadamente 30 quadros por segundo. Os equi-pamentos utilizados foram um laptop com processador IntelCore 2 Duo T7250 2 GHz, equipado com 4 GB de memoriaRAM, placa de vıdeo Nvidia GeForce 8400M GS 128 MBe Windows 7 (versao 64 bits). A camera utilizada para cap-tura das imagens foi uma Logitech QuickCam Pro 5000. Aestrutura utilizada pode ser visualizada na Figura 4.

Figura 4. Estrutura utilizada nos testes de de-sempenho e estabilidade.

6 Resultados

Nesta secao sao apresentados os resultados dos testesdescritos na secao 5 e o prototipo desenvolvido para ava-liar a interface de interacao tangıvel baseada no cubo.

VII Workshop de Realidade Virtual e Aumentada (WRVA'2010), São Paulo(SP), 08 a 11 de Novembro de 2010

16

6.1 Estabilidade da interface

Inicialmente foram mantidas tres faces visıveis, comomostrado na Figura 5, e respeitou-se a denominacao indi-cada na mesma Figura. Em seguida, ocultou-se outras facespara manter visıveis, duas e uma face respectivamente.

Figura 5. Imagem do cubo, com tres facesvisıveis, sobre o tripe.