VERIFICACIÓN DE LOS MODELOS METEOROLOGICOS

Transcript of VERIFICACIÓN DE LOS MODELOS METEOROLOGICOS

IDEAM-METEO/0001-05 NOTA TECNICA DEL IDEAM

Original: marzo 2005

VERIFICACIÓN DE LOS MODELOS METEOROLOGICOS Gloria León Aristizábal

SUBDIRECCION DE METEOROLOGIA INSTITUTO DE HIDROLOGIA, METEOROLOGIA Y ESTUDIOS AMBIENTALES -

IDEAM Bogotá, D.C.

CONTENIDO

1. INTRODUCCIÓN. 4

2. TIPOS DE PRONÓSTICOS Y TIPOS DE VARIABLES 5

2.1. Tipos de pronósticos 5 2.2. Tipos de variables 6

3. MEDIDAS DE CALIDAD 6

4. LA VERIFICACIÓN DE LA EXACTITUD DEL MODELO 7

5. ERRORES DEL MODELO 7

6. MEDIDAS ESTADÍSTICAS DE ERRORES TOTALES, SISTEMÁTICOS Y ALEATORIOS 8

7. PRONÓSTICOS CATEGÓRICOS DE VARIABLES ESCALABLES 9

7.1. RMSE/MAE 10 7.2. Error del sesgo (BE) 11

7.3. Desviación estándar (a)) 12 7.4. Error del vector (RMSVE) 12 7.5. Habilidad 13

7.6. Medidas Espaciales 14

8. PRONÓSTICOS CATEGÓRICOS DE VARIABLES NO ESCALABLES 18

8.1. Fiabilidad 18

8.2. Exactitud 19

8.3. Habilidad 20

9. PRONÓSTICOS PROBABILÍSTICOS DE VARIABLES NO ESCALABLES 22

9.1 Fiabilidad 23

9.2. Exactitud 24

9.3. Habilidad 25

10. PRONÓSTICOS PROBABILÍSTICOS DE VARIABLES ESCALABLES 25

PREDICCIÓN A 26

10.1. Fiabilidad 26

10.2. Exactitud 26

10.3. Habilidad 28

11. LIMITACIONES E IMPACTOS EN LA VERIFICACIÓN 28

11.1. Limitaciones de los pronósticos de modelo de grilla 29 11.2. Técnicas y fuentes de datos de las herramientas del modelo verificación 29

12. HERRAMIENTAS CORRECTAS PARA TIEMPOS CORRECTOS 32

12.1. Impacto de las medidas totales del error 33

12.2. Ejemplo del error de sesgo (Sistemático) 34 12.3. Ejemplo del error aleatorio con la desviación estándar 35 12.4. Impacto de las medidas estadísticas para un pronóstico individual 36

12.5. Impacto del período de tiempo y del dominio espacial 36

2

12.6. Diagnostico del funcionamiento del modelo a corto plazo a nivel local 37 12.7. Ejemplo de BE para Periodo/Dominio promedio 38

REFERENCIAS: 39

3

INSTITUTO DE HIDROLOGÍA, METEOROLOGÍA Y ESTUDIOS AMBIENTALES - IDEAM

SUBDIRECCIÓN DE METEOROLOGÍA

VERIFICACIÓN DE LOS MODELOS METEOROLÓGICOS

1. INTRODUCCIÓN

La evaluación de los modelos ha sido tradicionalmente subjetiva, teniendo en consideración la experiencia del pronosticador para determinar la exactitud de los mismos. Esta verificación se puede hacer por comparaciones simples, entre la salida modelo, con los análisis gráficos y las imágenes de satélites y diagramas de los datos de superficie y de altura. Sin embargo, estas comparaciones pueden ser engañosas puesto que contienen a menudo sesgos e impresiones personales.

En la medida que los modelos son más complejos y cambian con más frecuencia, se requieren medios más objetivos de evaluar el funcionamiento de ellos, tanto para eliminar sesgos específicos como para determinar el impacto del modelo en el cambio de las correcciones de errores conocidos. Las herramientas de evaluación de la exactitud del modelo, también llamadas verificación del modelo de diagnóstico o del modelo, se han desarrollado para proporcionar una medida objetiva de su habilidad, que puede ser utilizada por los pronosticadores.

La verificación del pronóstico equivale a determinar su calidad. Existen muchas razones para querer verificar los pronósticos, que en general pueden clasificarse en tres categorías:

• Razones administrativas. Comparación de los méritos relativos de los meteorólogos o de los sistemas de pronóstico, como un medio de evaluación de su funcionamiento.

• Razones diagnósticas. Valoración de los aciertos y de los fallos de los meteorólogos o de los sistemas de pronóstico, con objeto de realizar mejoras concretas..

• Razones económicas. Suministro de información que permita a los usuarios obtener todas las ventajas posibles de los pronósticos.

• Las anteriores son categorías generales; algunos de los usos más específicos que incluyen son los siguientes:

4

• Hacer elecciones razonadas entre métodos de pronóstico. • Controlar la calidad de los pronósticos. • Registrar los cambios en la calidad de los pronósticos a lo largo del tiempo. • Decidir sobre la distribución de recursos. • Establecer prioridades de investigación. • Investigar límites de predictibilidad.

La verificación es un aspecto importante del proceso de pronóstico. Para decidir cómo hacer la verificación, se debe revisar sobre las variables a predecir, y sobre el tipo de pronósticos que se hacen.

Las imágenes de satélite son frecuentemente utilizadas para cambiar la evolución de los modelos, para que éstos reflejen el estado real de la atmósfera.

Las imágenes de satélite pueden también ser utilizadas para elegir entre modelos cuando existen varios modelos numéricos a nuestra disposición (Euromet, 1997).

2. TIPOS DE PRONÓSTICOS Y TIPOS DE VARIABLES

El método de verificación que se elige depende del tipo de pronóstico, del tipo de variable a predecir y del contexto en que se utilizarán los resultados de la verificación.

2.1. Tipos de pronósticos

Existen dos tipos de pronóstico:

• Pronósticos categóricos o determinísticos. Consisten en afirmaciones que indican que ciertos eventos (o valores de variables) particulares van a ocurrir o no - los pronósticos se indican sin cualidades. Por ejemplo, "esta noche va a llover" o "mañana la temperatura subirá hasta 25°C".

• Pronósticos probabilísticos. Consisten en afirmaciones sobre la probabilidad de que ocurra un evento. Por ejemplo, "esta noche hay un 80% de probabilidad de que llueva" o "hay un 10% de probabilidad de que la temperatura suba más de 3°C sobre la normal".

Esos dos tipos de pronósticos están relacionados: los pronósticos categóricos son de hecho pronósticos probabilísticos en las que las únicas probabilidades que se utilizan son O y 1.

5

2.2. Tipos de variables

Así como existen dos tipos de pronósticos, también se utilizan dos tipos de variables:

• Variables escalables. Son variables que toman un valor en una escala continua o discreta (por ejemplo, la temperatura o la velocidad del viento). Normalmente una escala que en principio parece continua en realidad es discreta, porque las variables sólo pueden especificarse con una exactitud determinada (por ejemplo, las temperaturas predichas generalmente sólo se expresan aproximándolas al grado más próximo). Algunas veces, las variables escalables se denominan "variables ordinales" o "variables de tipo magnitud". Nótese que un rasgo esencial de esas variables es que están escaladas de tal forma que la distancia numérica entre valores o entre estados tiene algún significado.

• Variables no escalables. Son variables que simplemente definen eventos que pueden ocurrir o no (por ejemplo, el tipo de precipitación: lluvia, nieve o aguanieve). Las variables no escalables se denominan a veces "variables nominales" o "variables de tipo categoría". Algunas veces, variables que pueden escalarse (por ejemplo, el estado del cielo: nublado, parcialmente nublado o despejado / soleado) se tratan como no escalables para propósitos de verificación.

Por tanto, los dos tipos de pronósticos, junto con los dos tipos de variables, proporcionan un conjunto de 4 casos para los cuales se requieren diferentes métodos de verificación. Entonces se debe escoger entre esos métodos, el que sea más adecuado para el contexto en el cual se va a utilizar el pronóstico. Pero antes de analizar los 4 casos, se examinará en primer lugar las medidas de calidad de las que se dispone.

3. MEDIDAS DE CALIDAD

Los pronósticos de alta calidad exhiben una estrecha correspondencia con las observaciones. Las tres medidas más comunes utilizadas para valorar la calidad son:

• Fiabilidad. El grado de correspondencia entre los pronósticos promedio y las observaciones promedio; esto a veces también se denomina sesgo porque es una medida de la tendencia sistemática en un conjunto de pronósticos hacia la sobre-estimación o hacia la sub-estimación.

• Exactitud. El grado promedio de correspondencia entre pronósticos individuales y las correspondientes observaciones. Esto significa que incluso un sistema de pronóstico equilibrado que tiene una fiabilidad ideal puede tener todavía un grado de exactitud pobre.

6

• Habilidad. La exactitud de una pronóstico en comparación con la exactitud de una pronóstico de referencia (es decir, pronósticos basadas en la climatología, la persistencia o la probabilidad). No tiene sentido abordar el problema de hacer un pronóstico si el resultado no difiere de lo que se obtendría al utilizar datos climatológicos. Por lo tanto, el índice de habilidad proporciona una medida de la justificación para utilizar un sistema de pronóstico particular.

4. LA VERIFICACIÓN DE LA EXACTITUD DEL MODELO

En su forma más ideal, la verificación de la exactitud del modelo se puede idealizar como una comparación simple del pronóstico del modelo y la verdad atmosférica según lo definido por el siguiente.

PRONOSTICO DEL MODELO

EXACTITUD

En realidad, esta comparación es obligada por las limitaciones los pronósticos del modelo y la representación de la verdad atmosférica.

5. ERRORES DEL MODELO

Las medidas estadísticas generadas de la comparación objetiva de los pronósticos del modelo y de la verdad atmosférica pueden proporcionar medios convenientes de describir y de resumir la exactitud modelo. Las fuentes del modelo pronostican los errores que definen esta exactitud pueden tener componentes sistemáticos y al

azar.

ERROR ALEATORIO

ERROR SISTEMATICO

ERROR TOTAL

Error total: resume la magnitud de todos los errores de pronóstico, tanto los del componente sistemático como los de azar. El error total puede proporcionar una evaluación más completa de la cantidad del error, pero es difícil descifrar las contribuciones de los componentes sistemáticos y del azar. Se puede obtener más información de la causa o la fuente del error examinando cada componente individualmente. Por lo tanto, las medidas de error total se deben utilizar conjuntamente con las medidas del error sistemático y/o del error al azar.

Errores sistemáticos: son errores que se repiten en un cierto plazo y pueden ser originados por factores específicos del modelo o al método de la verificación. Por ejemplo, un modelo puede pronosticar constantemente temperaturas superficiales

7

= (Error sistematico) + (Error aleatorio) (Error total) Error

Ea Pronostico Tic COUET P rowam

excesivamente frías debido a una mala representación del modelo del terreno o de un problema en el esquema de la radiación. Los errores sistemáticos tienen magnitudes constantes que puedan ser fácilmente identificables. Pueden ser considerados con el desarrollo modelo adicional de tipo subjetivo o incluso corregirlo.

Errores al azar o no sistemáticos: se presentan a causa de la inhabilidad de medir totalmente la atmósfera o de predecir cambios periódicos en ella. Por ejemplo, la convección térmica puede generar errores al azar puesto que ocurre a menudo aleatoriamente sobre un área y en gran parte en una escala que no pueda ser representada. Aunque los errores al azar son imprevisibles y no pueden ser corregidos fácilmente, pueden ser descritos matemáticamente así como su efecto sobre el pronóstico estimado estadísticamente Los errores al azar proporcionan una medida de confianza (o de carencia de él) de lo que se pueda esperar de un pronóstico.

6. MEDIDAS ESTADÍSTICAS DE ERRORES TOTALES, SISTEMÁTICOS Y ALEATORIOS

Diversas medidas estadísticas se pueden utilizar para determinar cada uno de las fuentes del error del pronóstico del modelo (total, sistemático y al azar).

MEDIDAS ESTADISTICAS

RMSE / MAE Sesgo (Error Medio) Desviacion estandar

• El error del sesgo (error sistemático) muestra una constante de compensación del pronóstico.

• El error aleatorio o al azar muestra las variaciones inconsistentes del pronóstico.

8

a./ /

Observación " •

— •iS a

di /*• 7 , • me

• / a

' / / /

`-f. . , •

-1 4 -2 0 2 4 G a 10

Predicción

PCI

CV

-. • •

•

• El error total es una combinación de las contribuciones de ambos tipos de error: sesgo y aleatorio.

Estas medidas de error trabajan bien para los pronósticos de temperatura, altura geopotencial, presión media al nivel del mar, velocidad del viento y precipitación (a cierto grado) (Comet, 2001). Sin embargo, medidas especiales son necesarias para:

• Parámetros del vector, tales como viento

• Concordancia del modelo con la exactitud espacial de la medida. Estas medidas son muy útiles para evaluar pronósticos de la precipitación.

7. PRONÓSTICOS CATEGÓRICOS DE VARIABLES ESCALABLES

En esta sección, se utilizarán predicciones de temperatura aproximadas al grado Celsius más próximo para ilustrar el método general utilizado para predicciones categóricas de variables escalables.

El siguiente diagrama de puntos muestra el gráfico de las temperaturas observadas frente a las temperaturas que fueron predichas para esas observaciones. La línea de 45° representa el conjunto de predicciones perfectas, y por tanto la distancia de un punto a esta línea está relacionada directamente con la magnitud del error de la predicción.

9

7.1. RMSE/MAE

Existen dos medidas comunes de exactitud que miden la distancia "promedio" entre las predicciones y las correspondientes observaciones, son el error cuadrático medio (mean square error - MSE) y el error absoluto medio (mean absolute error - MAE). Ambas medidas tienen valor cero para pronósticos perfectos.

Frecuentemente se utiliza la raíz del error cuadrático medio (root mean square error, RMSE) en vez del MSE porque tiene las mismas dimensiones que la variable original. La utilización del MSE o del RMSE para medir la exactitud tiene dos inconvenientes principales:

• Su utilización fomenta pronósticos conservativos (es decir, aquellos próximos a la media climatológica) porque los errores grandes se penalizan fuertemente.

• No proporcionan estimaciones estables de la exactitud para muestras pequeñas porque los resultados pueden estar condicionados por unos pocos errores grandes.

La utilización del MAE también fomenta los pronósticos conservativos, pero este problema es menor que para el caso del MSE, que es particularmente sensible a los grandes errores. Sin embargo, para muestras grandes, en las que tanto los pronósticos como las observaciones tienen distribuciones simétricas (la media y la mediana son similares), el MAE y el RMSE deberían ser similares.

7.1.1. Error cuadrático medio (RMSE)

El error cuadrático medio es la raíz cuadrada del promedio del cuadrado de las diferencias ajustadas individuales entre el pronóstico (fn ) y la observación (on), donde N es el número total de comparaciones pronosticadas.

N 1,1

RMSE 7. H. r (fn - 0n )2

n=1 Error Total

El cuadrado de esta diferencia fuerza el RMSE para tener en cuenta tanto los errores positivos y negativos, así el RMSE hace la medida del error total del modelo. La medida del error total, RMSE incluye los componentes sistemáticos y al azar, los cuales se pueden separar usando medidas para el error sistemático y el error al azar, tales como error de sesgo y desviación de estándar.

RMSE se utiliza a menudo para evaluar la magnitud del error en un pronóstico de temperatura, vientos y alturas geopotenciales.

10

7.1.2. Error absoluto medio (MAE)

N

MAE = :IN- lff,- °n i i Magnitud del Error Total

El error absoluto medio es el promedio del valor absoluto de la diferencia entre el pronóstico (fn) y la observación (o n), donde N es el número total de comparaciones pronosticadas. Tomar el valor absoluto de esta diferencia fuerza a MAE a tener en cuenta, tanto errores positivos como negativos, así MAE hace la medida del error total del modelo.

MAE se utiliza para evaluar la magnitud del error en un pronóstico de temperatura, vientos y alturas geopotenciales.

7.2. Error del sesgo (BE)

El error del sesgo es una medida de la fiabilidad del modelo.

Para un conjunto de N pronósticos de este tipo, la medida de fiabilidad es el error medio, definido como:

N 1 BE .7. Fi 1 (fn -On)

n=1 Error sistemático I sesgo

El error de sesgo es el promedio de la diferencia entre el pronóstico (fn) y la observación (on), donde N es el número total de pronósticos comparados. Debido a que BE carece del término en valor absoluto o al cuadrado, se permite la cancelación de errores individuales positivos y negativos, poniendo en evidencia solamente el exceso, es decir el error sistemático.

BE representa la desviación promedio entre los pronósticos y las observaciones. Si BE es positivo, los valores pronosticados tienden a superar a los observados, mientras que si el sesgo es negativo sucede lo contrario.

El error de sesgo, generalmente se utiliza para evaluar la magnitud de la sobrestimación o subestimación de variables, tales como: temperatura, viento, altura, etc. Los valores negativos representan una subestimación o subvaloración, los valores positivos representan un sobrestimación o sobrevaloración y un valor cero significa que no hay sesgo.

En algunos casos se elimina el sesgo en los pronósticos del modelo, mediante la simple substracción del BE a los pronósticos individuales antes de que sean

11

divulgados. Sin embargo, esta corrección no es recomendable hacerla si los pronósticos proceden de diferentes meteorólogos, cada uno de los cuales va a efectuar un sesgo distinto. En estas circunstancias, la eliminación del sesgo de conjunto podría tener un efecto adverso sobre la exactitud. La forma de mejorar los pronósticos consiste en que los meteorólogos individualmente reduzcan el sesgo en sus propias pronósticos.

7.3. Desviación estándar (a))

1 N1 i2

N - 1 olti ( en - I I

Variabilidad del pronóstico

La desviación estándar es la raíz cuadrada del cuadrado del promedio de la diferencia entre el error de pronostico (e n = fn —on ) y el error medio de pronostico (e ),donde N es el número total de pronósticos comparados.

• f„ es un pronostico especifico

• o, es una observación especifica

ces usado para medir la cantidad de variabilidad en el pronóstico de las variables meteorológicas. Valores altos de a indican una alta variabilidad en el pronóstico. Estadísticamente se puede demostrar que aproximadamente el 67% del tiempo la componente aleatoria del error total del modelo estará dentro de una desviación estándar y el 95% dentro de dos desviaciones estándar. Así, la desviación estándar se puede utilizar como un registrador del rango previsto de la contribución aleatoria o no-sistemática en el error total del pronóstico, aunque la magnitud exacta del error aleatorio variará extensamente (y puede cambiar la muestra) de caso a caso.

7.4. Error del vector (RMSVE)

El vector del error cuadrático medio (RMSVE) es simplemente el RMSE aplicado a las magnitudes del pronóstico y de las componentes observadas del vector. En el ejemplo anterior, RMSVE se calcula para los vientos horizontales, usando la raíz cuadrada de la suma de las diferencias ajustadas entre las magnitudes del pronóstico (uF y vf) y (u0 y yo) componentes observados del viento. Los vectores de u y de y corresponden a las componentes este-oeste y norte-sur del viento, respectivamente.

12

Observado 315° con 12 kts

Pronosticado 360° con 10 kts

u=106icts

v = -10 8 kts

u •-•-• 0 las

V = -10 kIS

N RNISVE r- [=

n=1tuf Iktj2 "1 sit - %do):

N

1 40.0 -1 0.6)2 4. (40 4, 10.8)] 2 .=

110.82 kt5 Tire CONItT Prog ram

u

7.5. Habilidad

La habilidad puede medirse mediante un Índice de Habilidad (Skill Score, SS) basado en cualquier medida de exactitud: MAE, MSE o RMSE. El índice de habilidad se define mediante la ecuación siguiente, por ejemplo, si se usa el MSE como medida de la exactitud, entonces:

SS = 1 MSE MSE,

Para una pronóstico perfecto, MSE=O. La elección habitual para el pronóstico de referencia es la climatología, en cuyo caso el MSE de referencia es la varianza de las observaciones alrededor de una media de largo plazo.

Por ejemplo, un índice de habilidad de 1 indica pronósticos perfectos, y un índice de cero significa que las temperaturas pronosticadas no son mejores que las resultantes de utilizar simplemente una temperatura media de largo plazo. Si SS<O, entonces los pronósticos son de hecho peores que el pronóstico de referencia.

13

H = Acierto F = Pronóstico O = Observado

Buena fiabilidad Mala fiabilidad Buena fiabilidad Buena exactitud Buena exactitud Mala exactitud

7.6. Medidas Espaciales

Mala fiabilidad Mala exactiitud

Las medidas estadísticas pueden también medir exactitud espacial, destacando el patrón y la ubicación correcta de un parámetro particular. Tales medidas incluyen las siguientes:

• Índice de amenaza ( Threat score -TS)

• Índice equitativo de amenaza (Equitable Threat score — ETS)

• Correlación

• Correlación de la anomalía

7.6.1. Índice de amenaza — IA ( Threat score -TS)

El índice de amenaza es una medida de la ubicación correcta y de sincronización de un pronóstico para un evento particular. El traslapo entre (F) pronosticado y la observación (0) para una ocurrencia se representa como un acierto (H). Los IA comparan el tamaño del área del pronóstico correcto con el área total donde el evento fue predicho u observado.

14

Pronóstico elbservación 1=I 3 0.14 0= 0

; .25 in • = 0.1D in . I= 5 0.5 in • = 025 in.

• = 0.5 in.

Generalmente, los IA se calculan para una cantidad umbral, la cual es una tasa de acierto para un evento particular que excede un valor específico. En el caso de la precipitación, ésta puede ser un índice para la cantidad de precipitación pronosticada que exceda un umbral de 0.1 pulgadas durante un periodo de tiempo (ver ejemplo). Los valores de los IA pueden extenderse a partir de la 0.0 a 1.0, donde un índice de 1 representa un pronóstico perfecto y un induce de cero no indica ninguna habilidad.

En el ejemplo, los intervalos sombreados de las isolíneas representan los pronósticos de precipitación total en seis horas. Los círculos pequeños representan observaciones igualmente espaciadas para el mismo período de tiempo. Los colores permiten identificar las diferentes cantidades de precipitación de acuerdo con las convenciones. En este caso, el pronóstico fue para que cuatro sitios con precipitación mayor o igual a 0.10 pulg., mientras que en la realidad ocho de los sitios observaron cantidades iguales o que excedían ese umbral (más de 0.10). Solamente en tres sitios observaron cantidades de precipitación mayor o igual a 0.10 pulg., coincidentes con el pronóstico.

El índice de amenaza para este caso (calculado para el umbral 0.10-in.) es 0.33. Observe que las observaciones usadas en el cálculo midieron realmente cantidades más altas que el umbral indicado (0.25, 0.25, y 0.50 pulg.). Recuerde que los 1A son una medida para todas las cantidades que exceden un umbral dado y no representan la habilidad de un pronóstico para esta cantidad específicamente. Hay que tener presente que este ejemplo es un caso ideal con observaciones igualmente espaciadas, lo cual raramente se da en la realidad.

15

7.6.2. Índice de amenaza equitativa - IAE (Equitable Threat Score - ETS)

El índice de amenaza equitativa es similar a los IA, donde la correlación entre (F) pronosticado y la observación (0) para una ocurrencia se representa como un acierto (H). Sin embargo, IAE considera además la ocasión al azar o aleatoria (C) de un pronóstico positivo correcto. (Los lA pueden recompensar los pronósticos correctos generados puramente por la ocasión y pueden ser engañosos.)

La ocasión se define como:

C = F x 0/N

N es igual al número total de las observaciones verificadas.

Los valores de IAE, así como los de 1A, iguales a 1.0 representan pronósticos perfectos, mientras que los valores acercan o el igual a cero representa pronósticos con poco o nada de habilidad. IAE puede tener valores negativos que representan una habilidad inferior de pronóstico que el de la ocasión al azar o aleatoria (IAE=0). Los valores de IAE son siempre más bajos que valores de los

lA.

ETS - H -C

F + O -H -C

7.6.3. Correlación - C

La correlación es una medida del "grado de ajuste," o de similaridad o semejanza, entre el pronóstico y los patrones observados. La correlación valora el rango entre -1 y 1, donde 1 representa la correlación perfecta y cero no hay ninguna correlación. Las medidas de correlación se utilizan mejor para los patrones de la onda continua tales como la altura geopotencial. La correlación se calcula sobre las n localizaciones, en donde f denota el pronóstico y o denota la observación.

(f, -7) X(Or, - 45) n =1 -

= N 1/2 \2 N I, \21

y •-" T x £ O [n 1 n n =1‘ n

-O

En el gráfico se ilustran comparaciones de patrones de ondas simples (a) correlación positiva, (b) correlación negativa y (c) no correlacionados.

16

Correlación para un patron de onda simple

N nI1[(t - C ri )(0,1 - C a )]

CA= , 11/2 ín=1 n n n=i n n)2 /(f -C YE(0 - C 1

7.6.4. Correlación de la anomalía (CA)

La correlación de la anomalía es una medida de similaridad entre el pronóstico y los patrones de observación usando anomalías (generalmente desviaciones del promedio climatológico) para un parámetro particular. La CA se utiliza bastante bien para los regímenes globales, donde la porción de flujo cambia lentamente (ondas largas) con carácter dominante pero no tiene un efecto principal en el tiempo. Remueve las ondas largas (climatología) y examina las características de pequeña escala (anomalías), CA puede enfocarse para los patrones significativos.

La exactitud del pronóstico usando CA es evaluada generalmente con respecto a un valor de referencia establecido. Valores para CA iguales o cercanos a 1.0 indican un perfecto o cercano a un perfecto pronóstico ( similares pronósticos y observaciones de los patrones de anomalía), mientras que por debajo del valor de referencia de 0.6, generalmente son de poco valor o nada de valor.

La correlación de anomalía se calcula sobre las localizaciones de N, en donde

• fr, denota el pronóstico

• on denota la observación

• Cr, denota el promedio climatológico del parámetro observado (o n)

17

8. PRONÓSTICOS CATEGÓRICOS DE VARIABLES NO ESCALABLES

Un ejemplo de variable no escalable es un sistema de dos estados, tal que la temperatura del suelo está por encima o por debajo del punto de congelación; en otras palabras, si el suelo va a congelarse o no.

Puesto que hay un pequeño número de estados, el equivalente del diagrama de puntos que se dibujó para variables escalables, es simplemente una tabla, como ésta:

Pronóstico

Observación Sí No Total

Sí H M H+M No F C F+C

Total H+F M+C N

Las variables son las siguientes:

H = Aciertos tipo 1 (Hits): número de veces en las que la congelación fue predicha y observada.

M = Fallos tipo 1 (Misses): número de veces en las que la congelación se observó pero no fue pronosticada.

F = Fallos tipo 2 (False alarms): número de veces en las que se predijo la congelación pero no se observó.

C = Aciertos tipo 2 (Correct rejections): número de veces en las que no se predijo la congelación, y no se observó.

Una tabla como ésta se denomina una tabla de contingencia, y se utiliza para determinar las tres medidas de calidad como en el caso anterior.

8.1. Fiabilidad

En este caso la fiabilidad es simplemente el número de pronósticos de congelación comparado con el número de veces en que se observó la misma; en otras palabras, se define la fiabilidad mediante el sesgo B donde:

=H+F 11+111

Por tanto, cuando B=1 los pronósticos son perfectamente fiables, mientras que B>1 y B<1 indican sobre-pronóstico y sub-pronóstico, respectivamente. Nótese de

18

nuevo que tener pronósticos fiables no garantiza que los pronósticos sean exactos.

8.2. Exactitud

Existen varias medidas que proporcionan una indicación de la exactitud de los pronósticos.

PC Porcentaje de aciertos (Percentage Correct): Es simplemente la razón de pronósticos correctos (tanto de congelación como de no-congelación), expresada como un porcentaje (o como una fracción) del número total de pronósticos.

.11+C PC _

N

El principal inconveniente de esta medida es que su valor está muy condicionado por los eventos más frecuentes (por ejemplo, para las pronósticos de lluvia / no lluvia, la categoría no lluvia es dominante en la medida PC).

FAR Razón de falsas alarmas (False Alarm Rate): Es una medida del número de pronósticos erróneos de un evento. Viene dada por el número de pronósticos incorrectos de un evento, dividido por el número total de pronósticos de ese evento, por tanto:

F FAR-

1-1+F

Para pronósticos perfectos, FAR=O.

SR Razón de éxitos (Success Rate): Lo contrario de FAR, es decir, SR=1-FAR.

POD Probabilidad de detección (Probability of Detection): Es una medida de la capacidad de predecir correctamente un evento. Viene dada por el número de pronósticos correctos del evento, dividido por el número de veces que se observa el evento:

19

POD -= H+M

H

Para pronósticos perfectos, POD=1. Nótese que el POD puede aumentar si se incrementa la frecuencia con la que se predice el evento. Sin embargo, debe tenerse cuidado para evitar que esto provoque un aumento en el FAR.

TS Índice de amenaza (Threat Score): Cuando se utilizan el FAR y el POD, el problema es que cada uno de ellos está influido solamente por un aspecto particular de los pronósticos. Para superar esto, puede utilizarse el índice de amenaza (Threat Score, TS), denominado también el índice crítico de éxitos. Se define como el número de pronósticos correctos de un evento, dividido por el número total de pronósticos, pero descontando todos los pronósticos correctos de la no-aparición del evento.

II TS =

H+F+M

Para cada evento, el TS solamente depende de los correspondientes FAR y POD. El índice varía entre O y 1, siendo TS=1 (POD=1 y FAR=O) para pronósticos que son todas correctas, y TS=0 (POD=O y FAR=1) cuando no hay pronósticos correctos.

También se utiliza a veces el término razón de éxitos, pero hay que tener cuidado porque puede referirse tanto al índice PC o al POD, y por lo tanto debe evitarse en lo posible.

Se ha visto que existen muchas medidas de la exactitud, proporcionando todas ellas alguna información útil sobre el sistema de pronóstico, pero ninguna de ellas aisladamente da toda la información. Por lo tanto, cuando se valora la exactitud de un conjunto de pronósticos, es mejor examinar toda una gama de medidas.

8.3. Habilidad

Los dos índices principales de habilidad que se utilizan para las pronósticos categóricas de variables no escalables son el índice de Habilidad de Heidke (Heidke Skill Score, HSS) y el Índice de Habilidad de Kuipers (Kuipers Skill Score, KSS).

20

El índice de habilidad de Heidke está basado en la medida PC de exactitud (utilizada en forma de fracción en vez de porcentaje), y se define de esta manera:

PC — PC c HSS =

1 — PC c

donde PCc es el porcentaje de pronósticos que se espera que sean correctas por casualidad. Esto puede calcularse considerando la siguiente tabla:

• La frecuencia con la que un evento es predicho es (H+F)/N.

• La frecuencia con la que un evento es observado es (H+M)/N.

• La frecuencia con la que, por casualidad, un evento es predicho correctamente es (H+F)(H+M)/N2 .

• La frecuencia con la que, por casualidad, un evento correctamente no es predicho y no es observado es (M+C)(F+C)//V2 .

Por lo tanto PCc es la suma de esas dos últimas frecuencias, y mediante sustitución en la ecuación y reordenamiento, se obtiene:

2(1/C — MF) HSS _

(II + M)(M + C) + (E. + F)(F + C)

Alternativamente, el índice de habilidad de Kuipers se define directamente en términos de los elementos de la tabla:

(IIC — MF) KSS =

(H + M)(F + C)

El KSS tiene dos ventajas sobre el HSS: En primer lugar, tanto los pronósticos aleatorios como los pronósticos constantes (persistencia) proporcionan una habilidad nula; en segundo lugar, la contribución al índice de habilidad hecha por

21

ZZ

'000Y0=6699Pv9Z se VO ap peppoeqaid

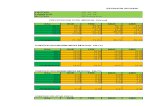

1 el ap oeldwa ap epuenom. si `oldwele Jod •soopouald ap ¡qm. oJewou ¡e Jod opllovqp euwnioo ap Jod epep auain ooRsouoid ap sapeppleciald sesJanip sel ueaidwa as anb uoo epuano94 e -1 •oeidwa ap epuanoald

• ',ovo se uopelidpaJd ap epemasqo epuenoe4 eI `osen elsa ua 'que]. 01 Jod . (6692) soopouald ap ieloT oJewnu Jod oppyqp (g8-frú u9peOpaJd ap e' ap ¡a iod epep aue'n uopei'dpaid ei auno() anb uoo epemasqo epuenoe4 •epuennoo ap epemasqo epuanoau

:!!fin ep!wnsai u9pewio4u! eun6ie asJenpap apand elsa ap J'ped

6698 617Z t Z99 Z1.9 699 00£ 1-17£ 179Z £1-9 t'99 1-Z9 6E'LZ mol

epemasqo 1.1913C4Idpaid

171-29 LL ZOG Z£1- t tZ 921- 891- 091- 96£ Z617 6EZ 61-9Z oN

gens ZZ1-1- 9817 09£ 99£ t7Z1. £Z1- t'1-1- 91-a Z91- Z£1. OZ1- 's

Mol 0'1, 6'0 9'0 2'0 9'0 g»0 ¡'CO 9'0 Z•0 1-'0 0'0

epensouoid dod

:alueJapp oBle oloadse un aua4 epua6upoo ap eigel ̀oluel oi lod 6 . 0 ••• `6•0 `0 . 0) sepo6aleo

ua ueluesaid as sapemqeqaid se! aluawieupou :oopouald sopese solionw uals!xe selsgmeqoad soopouaid eJed `olieqwe •sopeTsa sop ap ewals's un sa sauopemesqo ap oTunfuoo la ionanu ea •eunBuiu ?Jqeq ou uaiq o u9pel!dpaid eunBie ?Jqeq ue'q o :(dod `uoRepdPaid 10 Álnicieciaid) uopepd'oald ap pepumeqad el ?Jezmln es `eneleose ou eiqepen ap oidwafa owoo `zan els3

S31EIVIVOS3 ON 5319VIIIVA 3CI S0311S1119V9O2Id S0311SONOdd '6

'011.1GAG

!ap epuenoaii. si aÁnuiws'p unBas eluawne quena un ap 01.00.1J00 ooRsouoJd eun

1

Rippl„rgaffil,111111 O 0.1 0.2 43 0.4 0.5 0.6 O.? 0.3 0.5 1

Probabilidad de predicción

Frecuencia observada/ Frecuencia de utilización ,,

9.1 Fiabilidad El sesgo es una medida de fiabilidad. Los pronósticos son fiables (es decir, no sesgadas) si, para cada probabilidad de pronóstico, la frecuencia con la que ocurre un evento es la misma que su probabilidad de pronóstico.

Por ejemplo, considera el sesgo del pronóstico de la probabilidad 0.4. La anterior tabla de contingencia muestra que se predijo una probabilidad de 0.4 en 264 ocasiones, y de ellas, se observó precipitación en 114 ocasiones. Por lo tanto, en las ocasiones para las que se predijo una probabilidad de 0.4, la frecuencia observada de precipitación fue 114/264 = 0.432. Esto muestra que hay un pequeño sesgo en el pronóstico de la probabilidad de precipitación de 0.4. Puede calcularse el sesgo en forma parecida para cada pronóstico de probabilidad.

Por lo tanto, para un sistema de pronóstico determinado, habrá 11 figuras separadas de fiabilidad. Esta información puede resumirse mediante el trazado de un diagrama de fiabilidad:

Esta figura es el diagrama de fiabilidad para los datos de PoP tabulados anteriormente. La línea roja representa una fiabilidad perfecta, y la línea negra es la fiabilidad real que se obtiene para cada probabilidad de precipitación. Las barras verdes muestran la frecuencia con la que cada probabilidad fue predicha realmente; esto proporciona una idea del error de muestreo para cada punto del gráfico de fiabilidad.

Por supuesto, puedes incluso representar el sesgo del sistema en conjunto; en este caso, el sesgo viene dado por:

23

B — Po

donde P es la probabilidad media de pronóstico, y Pc, es la frecuencia con la que

realmente ocurrió la lluvia. Al utilizar esta medida, un pronóstico perfectamente fiable puntúa un 0%, con valores negativos para la sub-pronóstico, y negativos para la sobre-pronóstico.

9.2. Exactitud

El Índice de Brier es la medida de exactitud más comúnmente utilizada para los pronósticos probabilistas. Es una medida del error cuadrático medio probabilista, y se calcula esencialmente de la misma forma que el error cuadrático medio (Mean Square Error, MSE).

Para una pronóstico con dos categorías, como las pronósticos de precipitación que hemos considerado, la ecuación del índice de Brier es la misma que la ecuación para el MSE:

1 `v BS = — E(F3 — 0 3 ) 2

1=1

donde F, es la probabilidad predicha de que ocurra el evento, y O, indica si el

evento ocurrió (O, = 1 si fue así y O, = 0 si no). Con esta definición, se obtendría

que BS=O en el caso hipotético de que todas las pronósticos fueran completamente exactas, y BS=1 en el caso hipotético de que todas fueran completamente erróneas.

Debe advertirse que el índice de Brier tiene tres propiedades particularmente apropiadas.

Premia los pronósticos fiables. Premia la disposición a discriminar entre eventos mediante la penalización de Los pronósticos en el rango intermedio de probabilidades. La exactitud se maximiza sólo si el meteorólogo (o meteoróloga) hace una pronóstico que corresponde a su criterio sobre si un evento va a ocurrir.

24

La definición anterior del índice de Brier se aplica cuando existen solamente dos posibilidades de observación (es decir, precipitación o no). Si hay más de dos, la forma más general del índice de Brier, para un conjunto de N pronósticos con K categorías, es la siguiente:

1 N K

BS = E E(F,, - 0, ) ) 2 2N i=-1J=.1

9.3. Habilidad

La habilidad de las pronósticos probabilistas viene dada por el índice de habilidad de Brier (Brier Skill Score, BSS), también conocido como índice de habilidad probabilista (Probability Skill Score, PSS). Está basado en el índice de Brier de las pronósticos, comparado con el climatológico (BSc).

BSS = BS - BS BS,

Por tanto, BSS=1 para pronósticos perfectas, y BSS=O si no hay habilidad en la pronóstico.

Uno de los inconvenientes del BSS es su sensibilidad a la exactitud de la pronóstico climatológica. Si BSc es pequeño (es decir, el denominador en la expresión para BSS es pequeño) se amplifica cualquier diferencia entre la pronóstico y la pronóstico climatológica. Esto hace que el índice sea bastante inestable, por lo que es esencial que se utilice una muestra grande. Idealmente, el valor de la probabilidad utilizado como pronóstico climatológico debería ser la frecuencia del evento a largo plazo. En la realidad, esto no está disponible frecuentemente por lo que se utiliza a menudo la frecuencia del evento durante el período de las pronósticos (aunque esto sea denominado como "climatología").

10. PRONÓSTICOS PROBABILÍSTICOS DE VARIABLES ESCALABLES

La forma en que se tratan los pronósticos probabilísticos de las variables escalables es muy similar al método para las variables no escalables. Sin

25

embargo, para las variables escalables el concepto de la distancia entre eventos es significativo. Es preferible que el esquema de verificación sea sensible a la distancia, en el sentido de que, cuanto mayor sea la concentración de probabilidades de predicción cerca del evento que ocurre, el índice sea mejor. Esto significa que no son adecuadas para las variables escalables las medidas de calidad que se han utilizado hasta ahora, ya que no son sensibles al orden. Por ejemplo, considera la siguiente tabla de contingencia.

Banda de temperatura 0°C->2°C 2°C->4°C 4°C->6°C 6°C->8°C 8°C->10°C

Predicción A 0.0 0.1 0.3 0.4 0.2

Predicción B 0.0 0.3 0.1 0.4 0.2

Observación o 0 0 1 0

Intuitivamente, la predicción A sería considerada "mejor" que la predicción B porque las probabilidades están mucho más concentradas en torno a la categoría 6°C->8°C que en la predicción B. Sin embargo, si se calcula el índice de Brier para cada predicción se encontrará que su valor es 0.5 en ambos casos. Claramente, el índice de Brier no es el ideal si los eventos son escalables.

10.1. Fiabilidad

En la práctica, la fiabilidad se calcula de la misma forma para las variables escalables que para las no escalables. Se construye una tabla de contingencia como la anterior, y entonces puede hacerse un diagrama de fiabilidad, y se calcula el sesgo en la misma forma que para las variables no escalables.

10.2. Exactitud

El Índice de Probabilidad de Categorías (Ranked Probability Score, RPS) se utiliza para valorar la exactitud de un conjunto de predicciones probabilistas de variables escalables. Está basado en el Índice de Probabilidad (Probability Score, PS), que simplemente es igual a (1-BS). El RPS es similar al PS, pero está basado en la distribución de probabilidad acumulada. Así, mientras el PS depende de la suma media de la diferencia (elevada al cuadrado) entre las distribuciones de probabilidad predichas y observadas, el RPS depende de la suma media de la

26

1 N K PS _ 1

2N E Di (.1

,3)2

i=1 j=1

()P. E - oik -

k=1

diferencia (elevada al cuadrado) entre las distribuciones de probabilidad acumulada predichas y observadas.

Utilizando la definición general del índice de Brier dado por la ecuación

1 N 1,j, BS = (F- 2N E, -

el índice de probabilidad para un conjunto de N predicciones en K categorías viene dado por

Para variables escalables, las K categorías son los intervalos, como los intervalos de 2°C utilizados en la tabla de la página anterior. Entonces se reemplazan las probabilidades predichas y observadas por las correspondientes probabilidades acumuladas, definidas de esta manera:

FP = E Fjk k=1

Entonces el índice de probabilidad de categorías viene dado por:

N K

RPS = 1 - E E(F». -O ,c-)2

(K 1

- 1 )1V i=i )=1

Tanto el PS como el RPS han sido formulados de tal forma que tienen valores positivos que varían entre O y 1; es decir, RPS=1 corresponde a una predicción perfecta. También, cuando solamente hay dos intervalos (por ejemplo, temperatura por encima o por debajo de 6°C), el RPS y el PS son iguales. La

RPSS = 1 - RPS,

RPS RPS,

EXACTITUD PRONOSTICO DEL MODELO

REPRESENTA A LA ATMOSFERA DIFERENTE DE LA REAL

única forma de obtener un índice perfecto es dar una probabilidad predicha de 1.0 a los eventos que ocurren. También, la concentración de probabilidades en torno a los eventos que ocurren da un índice mejor que la dispersión de las mismas en todas las categorías.

10.3. Habilidad

Sin duda habrás imaginado que en este caso el índice de habilidad está basado en el RPS, para obtener el Índice de Habilidad Probabilístico de Categorías (Ranked Probability Skill Score, RPSS). En éste se compara el RPS con el proporcionado por las predicciones basadas en la climatología (RPSc). El RPSS tiene la forma usual:

Para predicciones perfectas RPSS = 1, mientras que valores menores que O indican que las predicciones no tienen habilidad (son peores que las climatológicas). Al igual que el BSS, el RPSS es inestable cuando se aplica a grandes muestras de datos.

11. LIMITACIONES E IMPACTOS EN LA VERIFICACIÓN

Como se mencionó, la verificación objetiva de la exactitud del modelo está supeditada por las limitaciones de los pronósticos del modelo y de la representación de la verdad atmosférica. Específicamente

• Los pronósticos del modelo representan la atmósfera como un arreglo discreto de valores promedios de áreas en comparación con los campos continuos encontrados en el mundo real

• La atmósfera real, contra la cual se comparan los pronósticos, es representada por las observaciones y análisis de la atmósfera. No importa

28

cómo lo sofisticada que sean las observaciones y los análisis, nunca representarán la atmósfera perfectamente.

11.1. Limitaciones de los pronósticos de modelo de grilla

Cómo los modelos y las observaciones / análisis representan la atmósfera contribuyen a errores en el pronóstico del modelo y le resta confiabilidad a las herramientas para la verificación de los modelos.

Puesto que la salida modelo es representada por valores en los puntos de grilla discretos que representan un promedio del área de la caja de grilla más bien que un valor para un punto específico del pronóstico, se deberá tener cuidado cuando se compare contra puntos de observaciones u otros datos de área promediados (es decir, diversas grillas).

Los datos de superficie del modelo son promediados para ajustar el modelo de topografía, que es una representación alisada del terreno real. Puesto que el modelo de superficie puede ser absolutamente diferente de la superficie real, las variables de pronóstico para el modelo de superficie no se pueden comparar exactamente con los datos de observación en superficie. Esto introduce errores adicionales de la representatividad en el proceso de la verificación.

Los datos del modelo usados en comparaciones tradicionales de pronóstico se pueden derivar de grillas de baja resolución en el postproceso, mejor que en la resolución de cómputo del modelo. Esto puede conducir a la interpretación incorrecta del funcionamiento del pronóstico, especialmente para los parámetros de niveles bajos y para la precipitación.

La atmósfera real contra la cual se comparan los pronósticos, es representada por las observaciones y los análisis de la atmósfera. No importa cómo sean de sofisticadas estas observaciones y análisis, nunca representarán la atmósfera perfectamente.

11.2. Técnicas y fuentes de datos de las herramientas del modelo verificación

La meta de la verificación del modelo es evaluar cómo de bien el modelo predijo el estado de la atmósfera. Para hacer esta tarea no solo se debe entender las fortalezas y las limitaciones del modelo que es evaluado, sino también la exactitud y la aplicabilidad de los datos de la verificación.

Tradicionalmente, las herramientas de verificación de modelos utilizan las técnicas y las fuentes de datos siguientes para representar la atmósfera real:

• Análisis del modelo

29

• Análisis objetivo independiente

• Observaciones puntuales

11.2.1. Análisis Modelo

Los análisis del modelo se diseñan para reducir al mínimo el crecimiento del error del pronóstico dentro de un sistema que modela más que representar las observaciones atmosféricas tan cerca como sea posible. Los análisis del modelo presentan típicamente una versión algo más lisa que el campo atmosférico real.

Los análisis del modelo son producidos generalmente mezclando el campo de la primera aproximación con el conjunto de datos observacionales. La primera aproximación se puede obtener de un pronóstico anterior o de datos pronosticados de otro modelo.

Los análisis del modelo incorporan múltiples tipos y fuentes de observaciones y pueden tener resolución espacial y temporal excelente. Pero son dependientes del número y de la calidad de las observaciones pasadas en el paquete del análisis. Los datos de observación que falta (tales como aquellas de eventos extremos rechazadas por el sistema de control de calidad de los análisis) pueden obstaculizar seriamente el análisis y falsificar la atmósfera. Si el análisis está demasiado influenciado por la primera aproximación, el modelo se validará.

Hay que recordar que los datos del modelo (tanto pronosticados como análisis) representan un promedio del área en cada punto de grilla. Usar el análisis de un modelo en la verificación de la exactitud puede ser muy útil, particularmente al comparar los tipos de datos. (Si son del mismo modelo, el análisis representa los mismos promedios de área que los pronósticos.) Sin embargo, usar los análisis del modelo pueden ser problemáticos y no representativos, especialmente cuando:

• Las resoluciones del análisis y del pronóstico no están bien emparejadas (es decir, diversas grita de resolución representan diversos promedios de área)

• La verificación de la exactitud generada a partir de un modelo (usando sus propios análisis) es comparada contra las medidas de otro (usando el análisis de un diferente modelo específico), hace que la comparación sea inconsistente.

11.2.2. Análisis Objetivo Independiente

Los análisis objetivos independientes de un conjunto de datos se generan solamente de observaciones a través de un sistema de análisis. (No hay modelo

30

de primera aproximación). Este conjunto de datos en grilla puede incorporar observaciones de fuentes múltiples y pueden tener resolución espacial y temporal excelente.

Algunas de ias características y de los rasgos de los análisis objetivos independientes de un conjunto de datos se enumeran a continuación.

Las observaciones faltantes o las observaciones que contienen datos inexactos pueden obstaculizar seriamente el análisis y conducir a inconsistencias significativas en la verificación del funcionamiento. La capacidad del esquema del análisis para señalar malos datos por medio de una bandera y de interpolarlos entre varias observaciones también afecta la calidad del análisis modelo.

La presencia de una alta densidad de observaciones y la disponibilidad de múltiples tipos de plataformas de observación tienden a mejorar la exactitud del análisis del modelo y son de gran ayuda para una mejor consistencia mejor en la verificación de funcionamiento.

Sin embargo, observaciones con alta densidad en los análisis de niveles bajos en localizaciones con el terreno complejo pueden no ser representativos.

11.2.3. Observaciones puntuales

Las observaciones puntuales son medidas directas de la atmósfera en puntos discretos. Aunque representan la más simple y la más directa muestra de la atmósfera, son limitadas por dos fuentes de errores significativos:

• Errores instrumentales se relacionan con el sistema de observación (el número de errores puede, en muchos casos, ser absolutamente alto)

• Errores de la representatividad (cómo bien una observación puntual representa el estado de la atmósfera alrededor de una localización particular). Las observaciones puntuales, tales como datos de radiosonda, son típicamente limitados espacial y temporalmente y pueden no ser una muestra al azar de la atmósfera

El hecho de que los pronósticos del modelo están representados como promedios del área sobre las cajas de grilla complica aun más la comparación de los pronósticos del modelo con las observaciones puntuales. Los promedios de la caja de grilla del pronóstico del modelo no son sinónimos con las observaciones puntuales usadas para la comparación (ver ejemplo). Para comparar los pronósticos del modelo con las observaciones, los datos del modelo se deben interpolar al punto de la observación, tomado el punto de grilla más cercano, o los datos dentro de cada caja de grilla deben ser promediados.

31

. .

0.0"

30 luto

Precipitación pronosticada por el modelo para elpunto de grilla A, que representa un área promedio sobre la caja de grilla (en este caso 30X30 lcm)

• 0.0"

071"

• • 0 7 1"

• 0,0"

1.5" •

0.0" A

0.3'

. 0.1"

• 0.5- • 44

.

Donde las obsrevaciones puntuales dentro de esta caja de grilla varía entre 0.0" y 1.5"

0.0' •

. 0" 1.5" .

0. 0.0" . • • • .

Promedio caja de grilla del modelo vs. Observaciones puntuales The COIJET Program

12. HERRAMIENTAS CORRECTAS PARA TIEMPOS CORRECTOS

Varias estrategias pueden ser de ayudan a los pronosticadores para hacer uso inteligente de las medidas estadísticas como herramientas objetivas de verificación de los modelos.

• Entender los tipos de errores que son medidos — cuál es corregible (errores sistemáticos) y cuál no son corregibles (errores aleatorios)

• Definir el problema del pronóstico actual. El gráfico abajo muestra pronósticos a un día contra siete días contra los diversos enfoques que se deben dar a los parámetros, escala de tiempo y escalas espaciales, y estas serán afectadas al cambiar los diferentes regímenes de tiempo.

32

Problemas de pronósticos más específicos.

Mención a: - Rasgos mesoescalaisinóptiros

Localización específica/área - Periodos cortos de tiempo

3.0

2.5

2

1.5

1

0.5

F000 F012 F024 F036 F048 (00 UTC) (12 UTC) (00 UTC) (12 UTC) (00 UTC)

700-hPa Temperature RMSE (°C) for 00- to 48-hr Forecast

The COM ET Program

'Pronóstico a 1 día

1

aífii

Ediciónpronósiico

Problemas de pronóstico general

Atención a: - Rasgas sinópticos/planetario' s - Arcas grandes - Periodos largos de tiempo

4

1 Estrategia verificación exactitud

- Objetivo en dominios espaciales y temporales específicos.

- Objetivo en parámetros específicos para elpronóstico (temperatura, punto de rocío y viento)

- Objetivo en medidas sobre grandes dominios espaciales y largos periodos de tiempo.

- Menos confianza en el pronóstico; objetivo en parámetros útiles para largas cabezas de pronóstico, tales como alturas

Ttic CO MET P nen nom

12.1. Impacto de las medidas totales del error

33

My' I F000 F012 F024 F038 F048

(00 UTCX12 UTC)(00 UTC)(12 UTCX00 UTC)

700-hPa Temperature Bias Error (°C) for 0000 UTC and 1200 UTC Valid Times

The COM ET Program

3

2

1

o

-1

-2

-3

Es difícil interpretar medidas del error total, tales como RMSE, sin entender las contribuciones de las componentes sistemáticas y aleatorias. Las medidas del error total se deben utilizar conjuntamente con medidas de los errores sistemáticos y/o aleatorios.

En el caso de crecimiento del error con el tiempo de pronostico, éste puede ser debido a las fuentes sistemáticas (corregible) o aleatoria (no corregible). Evaluando las componentes de los errores sistemáticos y aleatorios así como el error total del modelo, se puede ganar más entendimiento en la causa o fuente del error que examinando cada componente individualmente.

12.2. Ejemplo del error de sesgo (Sistemático)

El error de sesgo (BE) es una medida del componente sistemático del error total, que se repiten en un cierto plazo y estos errores sistemáticos pueden ser originados por factores específicos del modelo o el método de verificación. Además, el error de sesgo ilustra la magnitud de la tendencia sistemática a subpronosticar o sobrepronosticar una variable particular.

En este caso, el error de sesgo para la temperatura exhibe (aunque es no idéntico en magnitud) un crecimiento similar al error mostrado por las medida de RMSE. También muestran una tendencia de las temperaturas pronosticadas, demasiado frías durante los periodos cálidos del día (0000 UTC) y se calientan también durante los periodos fríos del día (1200 UTC). (Note que el crecimiento del error sobrepuesto en esta tendencia ha causado un sesgo frío en el pronóstico a 48, mayor en magnitud que el de la inicialización y el pronóstico a 24horas.)

34

Dado que el error de sesgo del ejemplo fue generado sobre una muestra grande, el error sistemático que representan puede ser corregido. Usando el ejemplo anterior y dado un pronóstico de temperatura a 24 horas de 10°C (en 700 hPa, válido para las 0000 UTC), el sesgo sistemático de -1.1°C se puede quitar fácilmente, produciendo un pronóstico ajustado de 11.1°C.

12.3. Ejemplo del error aleatorio con la desviación estándar

o F000 F012 F024 F038 F048

700-hPa Temperatura Standard DeviatIon ('C) for 00- to 48-hr Forecast

La desviación estándar es una medida del componente aleatorio o no-sistemático del error total y que los errores aleatorios se presentan por la inhabilidad para medir totalmente la atmósfera o para predecir sus cambios periódicos. En el ejemplo, el componente aleatorio medido por la desviación estándar no domina el error total; de hecho, la mayor parte del error parece ser sistemático y fácilmente corregible. En este caso, tanto RMSE y BE exhiben crecimiento del error con el plazo de obtención (la componente aleatoria del error para un pronóstico a 48 horas es mayor que el de la inicialización modelo).

Aunque los errores al azar son imprevisibles y no pueden ser corregidos fácilmente, pueden ser descritos matemáticamente y su efecto sobre el pronóstico puede ser estimado estadísticamente. Además, se puede demostrar que aproximadamente el 67% de los casos, la componente aleatoria del error total del modelo se encuentra dentro de una desviación estándar y que el 95% dentro de dos desviaciones estándar. Así, la desviación estándar se puede utilizar como una

35

medida del nivel de confianza que se puede esperar para pronosticar, contabilidad para los errores aleatorios.

Por ejemplo, en este caso, la desviación estándar de la temperatura a 24 horas en 700 hPa es 0.35°C. Esto significa que se espera que 67% de los pronósticos de temperatura (el componente aleatorio del error para pronósticos a 24 horas) tengan un error de 0.35°C (o de 0.7°C el 95% de los casos) con respecto del real. Adicionalmente, se puede aplicar a los pronósticos corregidos por el error sistemático. (En este caso, el sesgo de -1.1°C se resta del pronóstico real de 10°C, produciendo un pronóstico ajustado de 11.1°C.) Así, se puede tener confianza (por lo menos el 95% de los casos) que después de quitar el error sistemático, el pronóstico a 24 horas se verificará entre 10.4°C y 11.8°C. De igual manera se aplica el mismo método al pronóstico a 48 horas (con una desviación estándar de 0.6°C y de un pronóstico ajustado de 12.3°C), la ventana " de confianza del 95% " es mayor (entre 11.1°C y 13.5°C). Esto significa que incluso después de remover el error sistemático del pronóstico, se debe tener menos confianza en el pronóstico a 48 horas debido a los efectos de los errores aleatorios.

12.4. Impacto de las medidas estadísticas para un pronóstico individual

Las medidas estadísticas generadas de comparaciones de pronósticos a partir de la corrida individual de un modelo, sin hacer un promedio temporal, se pueden utilizar para tratar la exactitud de la inicialización modelo actual así como el funcionamiento de pronósticos recientes. Tales medidas consisten en estadísticas para localizaciones individuales o sobre promedios de dominios espaciales.

Debido a que las medidas estadísticas para un pronostico individual no son promediadas en el tiempo, son mucho más sensibles a los errores del modelo con respecto al sistemas meteorológicos de tiempo o a regímenes específicos de similar período y alcance. Por lo tanto, el conocimiento del tiempo actual y el previsto es crucial. Los cambios previstos del tiempo pueden hacer las medidas estadísticas anteriores o actuales inaplicables. Las verificaciones del pronóstico individual también son muy susceptibles a los problemas internos de los análisis modelo.

12.5. Impacto del período de tiempo y del dominio espacial

La estadística generada sobre períodos excesivamente largos enmascara los errores específicos a escalas de tiempo más pequeñas, quedándose por fuera de la señal de los errores individuales (es decir, puede reducir al mínimo los efectos de errores aleatorios en regiones específicas).

36

La estadística generada sobre períodos excesivamente cortos es más susceptible (e incluso dominada) por los errores específicos de regímenes localizados y puede no ser representativa del funcionamiento del modelo total. Sin embargo, estas medidas son útiles para resaltar la exactitud con respecto a regímehes de escala de tiempo similares. Por ejemplo, las medidas estadísticas generadas sobre tres a cinco días se pueden utilizar para encontrar los errores asociados a los regímenes específicos de tiempo, tales como la intensificación de dorsales en niveles superiores. En situaciones de regímenes que cambian rápidamente, incluso para estadísticas promediadas de corto tiempo pueden ser engañosas. El conocimiento de las condiciones de tiempo meteorológico actual y el funcionamiento del modelo a lo largo del flujo es crucial.

La estadística generada sobre dominios excesivamente grandes, tales como el hemisferio norte, enmascaran los errores de pequeña escala asociados con regiones o localizaciones. Tales medidas son más probables a destacar los errores del modelo que son independientes de regiones específicas.

La estadística generada para regiones muy pequeñas o localizaciones aísla los errores asociados a esas áreas. Por ejemplo, la estadística generada sobre zonas de montaña o en las costas de un golfo es más específica para esas regiones y útil para los pronosticadores que las medidas generadas sobre el dominio entero.

Las combinaciones estadísticas promediadas temporalmente y espacialmente son muy útiles.

12,6. Diagnostico del funcionamiento del modelo a corto plazo a nivel local

Las medidas mensuales en una localización particular son más apropiadas para el diagnóstico del funcionamiento del modelo a corto plazo a nivel local. Las medidas hechas promediando períodos excesivamente largos (meses o estaciones) o dominios grandes son más probables para enfocar errores generales del modelo. Los conjuntos de datos sobre grandes dominios pueden enmascarar los errores locales, tales como errores locales del viento o de la temperatura, aunque los errores locales estén contenidos dentro del conjunto de datos.

Las medidas semanales deben ser más útiles para identificar funcionamiento modelo a corto plazo puesto que pueden ayudar a identificar los s cambios a más corto plazo de los regímenes de tiempo. Si el régimen actual de tiempo es diferente del pasado reciente, el funcionamiento del modelo puede también ser diferente, haciendo aun más engañoso el funcionamiento estadístico. Igualmente, las medidas mensuales pueden hacer un promedio por fuera del funcionamiento del modelo sobre el curso de varios cambios de regímenes de tiempo, dejando al

37

pronosticador sin la manera razonable de juzgar la validez de la estadística para el régimen actual.

12.7. Ejemplo de BE para Periodo/Dominio promedio

El gráfico muestra el sesgo (BE) de la temperatura (°C) de las salidas para 500 hPa del modelo MRF 500-hPa de los pronósticos promedios a 48 horas para diversos de diversos dominios (Norteamérica, Rapid City, SD) y períodos (julio 1999 y periodo de siete días finalizando el 1 de agosto de 1999), tan bien como el error real en Rapid City para el pronóstico a 48 horas pronosticó, válido el 1 de agosto 1999 (UTC de 0000).

MRF 500-hPa Temperature BE's re) for 441-hr Forecasts

2

Note que el BE generado del promedio mensual sobre Norteamérica (N.A. mensual) es ligeramente positivo, indicando una tendencia sistemática a la excedencia de las temperaturas pronosticadas a este nivel sobre Norteamérica para julio de 1999. El BE generado para Rapid City, para julio 1999 (UNR mensual) y el del período de siete días (UNR 7 días) son negativos, indicando una tendencia a subpronosticar las temperaturas para Rapid City a este nivel y época del año.

El error real para el pronóstico a 48 horas, válido el 1 de agosto, es negativo y más grande en magnitud que el BE del promedio. Esto no debe sorprender, considerando que las medidas hechas con promedio pueden incluir la cancelación de los errores positivos y negativos, que pueden ser causados por los cambios en los regímenes o patrones de tiempo. Mientras que las medidas generadas para los promedios sobre Rapid City representan la tendencia negativa considerada el error real, el promedio de siete días captura la magnitud lo más cercana posible. En

38

este caso, los ajustes hechos al pronóstico que usa el promedio de BE para siete días en Rapid City producirían un pronóstico más representativo.

En este caso, el BE mensual generado sobre Norteamérica no es representativo del error real y cualquier ajuste hecho al pronóstico no serían útil. Una vez más las medidas hechas sobre un promedio (especialmente para períodos largos y dominios grandes) pueden contener considerable cancelación de errores positivos y negativos. Por ejemplo, el promedio de Norte América puede incluir los sesgos asociados a otros sub-dominios o localizaciones que sean más significativos que los considerados en UNR.

Hay que observar que pueden haber casos que implican cambios del régimen o pasos frontales donde los ajustes usando los errores de sesgo de cortos periodos pequeños dominios no son útiles.

REFERENCIAS:

• Arakawa, A., 1972: Design of the UCLA general circulation model. Tech. Report No. 7, Department of Meteorology, University of California, Los Angeles, 116 pp.

• Baldwin, M. E., and S. P. Hrebenach, 1998: Experiments with bias-corrected temperature guidance using NCEP's mesoscale Eta model. Preprints, 16th Conf. On Weather Analysis and Forecasting, Phoenix, AZ, Amer. Meteor. Soc., 388-389.

• Benjamin, S.G., K.J. Brundage, and L.L. Morone, Cited 2000: Implementation of the Rapid Update Cycle Part I: Analvsis/Model Description. NOAA/NWS Technical Procedures Bulletin, NOAA/ERL Forecast Systems Laboratory, Boulder, CO, 1994.

• Caplan, Peter, and Suranjana Saha, 1998: Further Chanqes to the 1998 NCEP Operational MRF Analysis/Forecast System. NWS Technical Procedures Bulletin No. 450.

• Carr, F.H., 1988: Introduction to Numerical Weather Prediction Models at the National Meteorological Center. University of Oklahoma, 63 pp.

39

• Carter, G.M., J.P. Dallavalle, and H.R. Glahn, 1989: Statistical forecasts based on the National Meteorological Center's numerical weather prediction system. Wea. Forecasting, 4, 401-412.

• Comet, 2001: Intelligent Use of Model-Derived Products.

• Dallavalle, J.P., 1996: A perspective on the use of model output statistics in objective weather forecasting. Preprints Fifteenth Conf. on Weather Analysis and Forecasting, Norfolk, VA, Amer. Meteor. Soc., 479-482.

• Euromet, 1997: Predicción Numérica. EUMETCAL Project. http://euromet.meteo.fr/

• Glahn, H.R., 1985: Statistical weather forecasting. Probability, Statistics, and Decision Making in the Atmospheric Sciences, A.H. Murphy and R.W. Katz, Eds., Westview Press, 289-335.

• Glahn, H.R., and D.A. Lowry, 1972: The use of model output statistics (MOS) in objective weather forecasting. J. Appl. Meteor., 11, 1203-1211.

• Holton, J., 1992: An Introduction to Dynamic Meteorology, 3d Ed., Academic Press, 511 pp.

• Hong, S-Y, and H-L Pan, 1996: Nonlocal boundary layer vertical diffusion in a medium-range forecast model, Mon. Wea. Rev., 124, 2322-2339.

• Lorenz, E. N., 1969: Atmospheric predictability as revealed by naturally occurring analogues. J. Atmos. Sci., 26, 636-646.

• Liou, K. N., 1992: Radiation and Cloud Processes in the Atmosphere: Theory, Observation and Modeling. Oxford University Press, 504 pp.

• Mao, Q., R.T. McNider, S.F. Mueller, and H. H. Juang, 1998: An optimal model output calibration algorithm suitable for objective temperature forecasting. Wea. Forecasting, 14, 190-202.

• Mesinger, F., 1996: Improvements in quantitative precipitation forecasts with the Eta regional and mesoscale models at the National Centers for Environmental Prediction. Preprints, 11 th Conference on Numerical Weather Prediction, Norfolk, VA, Amer. Meteor. Soc., J107-J018.

• Mesinger, R., and T. L. Black, 1992: On the impact of forecast accuracy of the step-mountain (Eta) vs. sigma coordinate. Meteor. Atmos. Phys., 50, 47-60.

• NCEP, cited 1999: The Medium-Range Forecast Model.

40

• Nutter, P. A., and J. Manobianco, 1998: Evaluation of the 29-km Eta Model. Part I: Objective verification at three selected stations. Wea. Forecasting, 14, 5-17.

• Nutter, P. A., and J. Manobianco, 1998: Evaluation of the 29-km Eta Model. Pad II: Subjective verification over Florida. Wea. Forecasting, 14, 18-37.

• Panofsky, H. A., and G. W. Brier, 1965: Some Applications of Statistics to Meteorology. Pennsylvania State University, University Park, 224 pp.

• Petersen, R.A., and J.D. Stackpole, 1989: Overview of the NMC production suite. Wea. Forecasting, 4, 314-322.

• Ross, B.B., 1986: An overview of numerical weather prediction. Mesoscale Meteorology and Forecasting, P.S. Ray, Ed., Amer. Meteor. Soc., 720-751.

• Sela, J., 1980: Spectral modeling at the National Meteorological Center. Mon. Wea. Rey., 108, 1279-1292.

• Sellers, P. J., 1993: Biophysical models of !and surface processes. Climate System Modeling, Kevin Trenberth, Ed., Cambridge University Press, 451-490.

• Sellers, P. J., Y. Mintz, Y. C. Sud, and A. Dalcher, 1986: A simple biosphere model (SiB) for use within general circulation models. J. Atmos. Sci., 43, 505-531.

• Stull, Roland B., 1993: An lntroduction to Boundary Layer Meteorology. Kluwer Ac.

• Treadon, R., 1993: The NMC Eta Model Post Processor: A Documentation. NMC Office Note No. 394, 42 pp.

• White, W. G., J. Paegle, W. J. Steenburgh, J. D. Horel, R. T. Swanson, L. K. Cook, D. J. Onton, and J. G. Miles, 1998: Short-term forecast validation of six models. Wea. Forecasting, 14, 84-107.

• Wilks, D.S., 1995: Statistical Methods in the Atmospheric Sciences. Academic Press, 467 pp.

• Wu, Wan-shu, Mark Iredell, Suranjana Saha, and Peter Captan, 1997: Changes to the 1997 NCEP Operational MRF Model Analysis/Forecast System. NWS Technical Procedures Bulletin No. 443.

41